如打印每一行的行数:

[root@localhost profile.d]# ls -lh | awk '{print NR " " $1}' 1 total 2 -rwxr-xr-x 3 -rwxr-xr-x 4 -rw-r--r-- 5 -rwxr-xr-x 6 -rwxr-xr-x 7 -rwxr-xr-x 8 -rw-r--r-- 9 -rw-r--r-- 10 -rw-r--r-- 11 -rw-r--r-- 12 -rwxr-xr-x 13 -rwxr-xr-x 14 -rwxr-xr-x 15 -rwxr-xr-x 16 -rwxr-xr-x 17 -rwxr-xr-x 18 -rwxr-xr-x这样再来看这段语句应该就很容易理解了:

root@Ubuntu:~# awk -F ':' '{printf("filename:%10s,linenumber:%s,columns:%s,linecontent:%s\n",FILENAME,NR,NF,$0)}' /etc/passwd filename:/etc/passwd,linenumber:1,columns:7,linecontent:root:x:0:0:root:/root:/bin/bash filename:/etc/passwd,linenumber:2,columns:7,linecontent:daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin filename:/etc/passwd,linenumber:3,columns:7,linecontent:bin:x:2:2:bin:/bin:/usr/sbin/nologin filename:/etc/passwd,linenumber:4,columns:7,linecontent:sys:x:3:3:sys:/dev:/usr/sbin/nologin filename:/etc/passwd,linenumber:5,columns:7,linecontent:sync:x:4:65534:sync:/bin:/bin/sync filename:/etc/passwd,linenumber:6,columns:7,linecontent:games:x:5:60:games:/usr/games:/usr/sbin/nologin 变量除了awk的内置变量,awk还可以自定义变量。

如下引入变量sum,统计py文件的大小:

root@ubuntu:~# ls -l *.py | awk '{sum+=$5} END {print sum}' 574 语句awk中的条件语句是从C语言中借鉴来的,见如下声明方式:

if语句

if (expression) { statement; statement; ... ... } if (expression) { statement; } else { statement2; } if (expression) { statement1; } else if (expression1) { statement2; } else { statement3; }循环语句

awk中的循环语句同样借鉴于C语言,支持while、do/while、for、break、continue,这些关键字的语义和C语言中的语义完全相同。

数组因为awk中数组的下标可以是数字和字母,数组的下标通常被称为关键字(key)。值和关键字都存储在内部的一张针对key/value应用hash的表格里。由于hash不是顺序存储,因此在显示数组内容时会发现,它们并不是按照你预料的顺序显示出来的。数组和变量一样,都是在使用时自动创建的,awk也同样会自动判断其存储的是数字还是字符串。一般而言,awk中的数组用来从记录中收集信息,可以用于计算总和、统计单词以及跟踪模板被匹配的次数等等。

使用数组,统计重复出现的次数:

[root@localhost cc]# cat test.txt a 00 b 01 c 00 d 02 [root@localhost cc]# awk '{sum[$2]+=1}END{for(i in sum)print i"\t"sum[i]}' test.txt 00 2 01 1 02 1 站点日志分析以下使用Linux中的Awk对tomcat中日志文件做一些分析,主要统计pv,uv等。

日志文名称:access_2013_05_30.log,大小57.7 MB 。

这次分析仅仅是简单演示,所以不是太精确地处理数据。

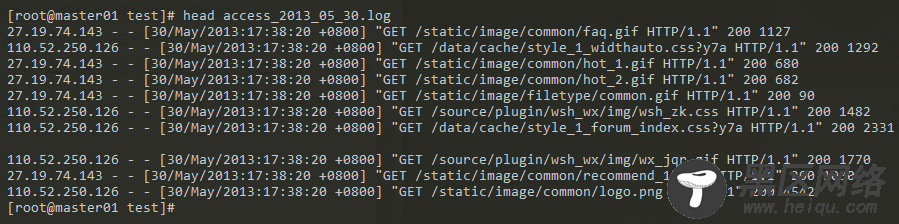

日志数据演示样例:

日志总行数:

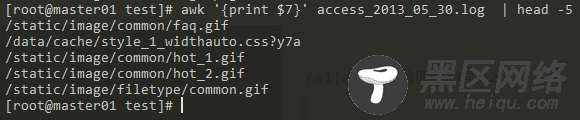

打印的第七列数据为日志的URL:

分析中用到的一些知识:

shell中的管道|

command 1 | command 2 #他的功能是把第一个命令command 1运行的结果作为command 2的输入传给command 2

wc -l #统计行数

uniq -c #在输出行前面加上每行在输入文件里出现的次数

uniq -u #仅显示不反复的行

sort -nr

-n:按照数值的大小排序

-r:以相反的顺序来排序

-k:按照哪一列进行排序

head -3 #取前三名

数据清洗: