打开项目的时候,IDEA会根据Maven工程的POM文件自动下载所需要的Jar包:

等待。。。。。。

终于jar包下载完成,打开了项目,如下图所示:

打开File–>Project Structure–>Platform settings–>SDKS选择Java的安装路径即可Apply即可

然后选择Setup JDK,就会自动识别我们刚才设置的的JDK

等待项目Updating……

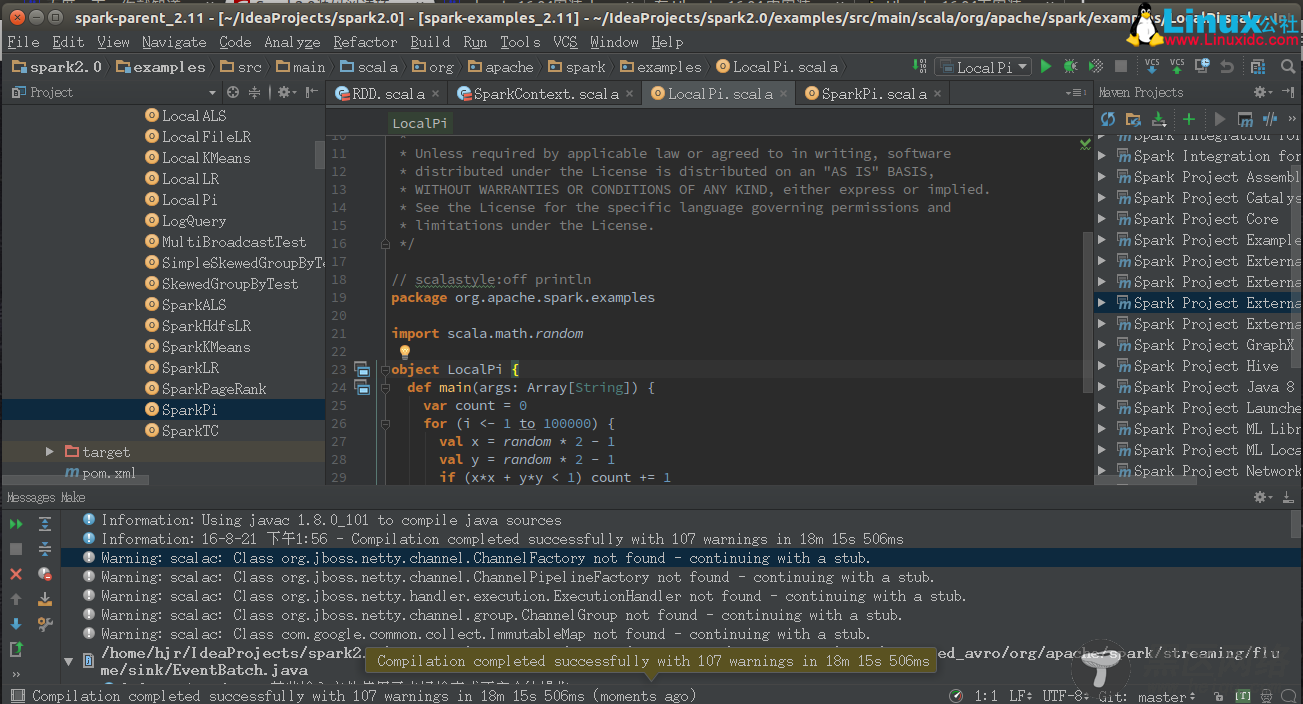

项目更新完之后效果如下图所示:(没有报错了)

有问题:(各种找不到呗) Error:(45, 66) not found: type SparkFlumeProtocol val transactionTimeout: Int, val backOffInterval: Int) extends SparkFlumeProtocol with Logging { Error:(70, 39) not found: type EventBatch override def getEventBatch(n: Int): EventBatch = { Error:(85, 13) not found: type EventBatch new EventBatch("Spark sink has been stopped!", "", java.util.Collections.emptyList())

这是下载jar包的时候,没有下载完全,再来一次就行,或者再来多次就行了。

View –> Tool Windows –> Maven Projects –>Generate Sources and Update Folders For All Projects(两个箭头首尾相连的那个按钮),然后等待…(这个过程如果你需要关闭idea,随意就行,因为重启idea后它会继续)

(我这里来了两次,终于下载完全了,现在是编译的过程,没有报错了,一大堆Warning…不管咯)

编译成功之后,如下图所示:

运行一个Example实例:

运行LocalPi,又报错了:

错误原因分析:Scala 的版本与 Spark2.0所使用的Scala版本不匹配

这里Spark2.0默认使用的是Scala2.11.8,所以我们也得将我们的Scala调整为Scala2.11.8

IDEA安装的Scala插件里所对应的Scala版本不是2.11.8,具体是哪个版本我们得查看一下。

更多Spark相关教程见以下内容: