Caffe刚刚安装配置结束,乘热打铁!

(一)环境准备

前面我有两篇文章写到caffe的搭建,第一篇cpu only ,第二篇是在服务器上搭建的,其中第二篇因为硬件环境更佳我们的步骤稍显复杂。其实,第二篇也仅仅是caffe的初步搭建完成,还没有编译python接口,那么下面我们一起搞定吧!

首先请读者再回过头去看我的《Ubuntu 16.04安装配置Caffe》( )

在这篇博文的结尾,我们再增加编译Python接口,而这部分内容请参考我的博文《 Ubuntu14.04搭建Caffe(仅cpu) 》 ,这篇文章从编译Python接口部分看就好了。

(二)下载模型

作者在github上开源了代码:Fully Convolutional Networks,我们首先将代码下载并且解压到家目录下。

项目文件结构很清晰,如果想train自己的model,只需要修改一些文件路径设置即可,这里我们应用已经train好的model来测试一下自己的图片:

我们下载voc-fcn32s,voc-fcn16s以及voc-fcn8s的caffemodel(根据提供好的caffemodel-url),fcn-16s和fcn32s都是缺少deploy.prototxt的,我们根据train.prototxt稍加修改即可。注意,这里的caffemode-url其实在各个模型的文件夹下面都已经提供给我们了,请读者细心找一找,看看是不是每一个文件夹下面都有一个caffemode-url的文件?打开里面会有模型的下载地址!

(三)修改infer.py文件

caffe path的加入,由于FCN代码和caffe代码是独立的文件夹,因此,须将caffe的Python接口加入到path中去。这里有两种方案,一种是在所有代码中出现import caffe 之前,加入:

1 import sys 2 sys.path.append('caffe根目录/python')

另一种一劳永逸的方法是:在终端或者bashrc中将接口加入到PYTHONPATH中:

export PYTHONPATH=caffe根目录/python:$PYTHONPATH

本次我们采用后者。

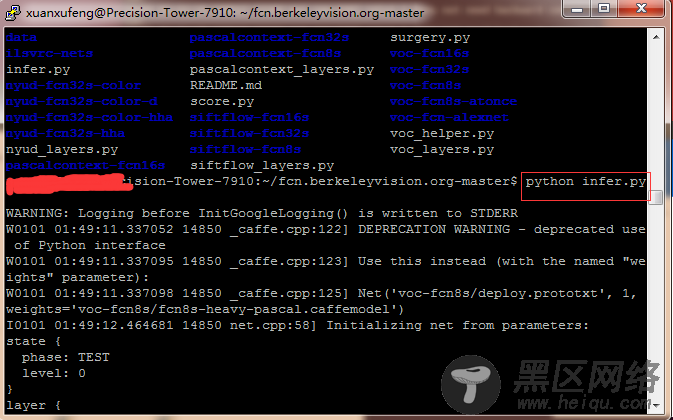

在解压代码的根目录下找到一个文件:infer.py。略微修改infer.py,就可以测试我们自己的图片了,请大家根据自己实际情况来进行修改。

im = Image.open('voc-fcn8s/test.jpeg') 这里指的是测试图片路径!

net = caffe.Net('voc-fcn8s/deploy.prototxt', 'voc-fcn8s/fcn8s-heavy-pascal.caffemodel', caffe.TEST) ,这里指的是voc-fcn8s文件下的部署文件和模型。注意,fcn下每一个模型其实都对应于一个文件夹,而每个文件夹下应当放着这个模型的caffemodel文件和prototxt文件!

plt.savefig('test.png') ,这里指的是最终分割的结果应当放置在哪个路径下,大家都知道,语义分割的结果应当是一张图片!

修改完后的infer.py如下所示:

1 import numpy as np 2 from PIL import Image 3 import matplotlib.pyplot as plt 4 import caffe 5 6 # load image, switch to BGR, subtract mean, and make dims C x H x W for Caffe 7 im = Image.open('voc-fcn8s/test.jpeg') 8 in_ = np.array(im, dtype=np.float32) 9 in_ = in_[:,:,::-1] 10 in_ -= np.array((104.00698793,116.66876762,122.67891434)) 11 in_ = in_.transpose((2,0,1)) 12 13 # load net 14 net = caffe.Net('voc-fcn8s/deploy.prototxt', 'voc-fcn8s/fcn8s-heavy-pascal.caffemodel', caffe.TEST) 15 # shape for input (data blob is N x C x H x W), set data 16 net.blobs['data'].reshape(1, *in_.shape) 17 net.blobs['data'].data[...] = in_ 18 # run net and take argmax for prediction 19 net.forward() 20 out = net.blobs['score'].data[0].argmax(axis=0) 21 22 plt.imshow(out,cmap='gray'); 23 plt.axis('off') 24 plt.savefig('test.png') 25 #plt.show()

运行结束后会在软件的根目录下生成一个分割好的图片test.png!

我们可以看一下原始图片和最后生成的图片的区别: