开发的大环境是Ubuntu 11.04,Hadoop 0.20.2,MyEclipse 9.1

首先要安装Myeclipse,在Ubuntu下安装Myeclipse和windows环境下安装的方法一样,下载myeclipse-9.1-offline-installer-linux.run然后双击运行就ok了。

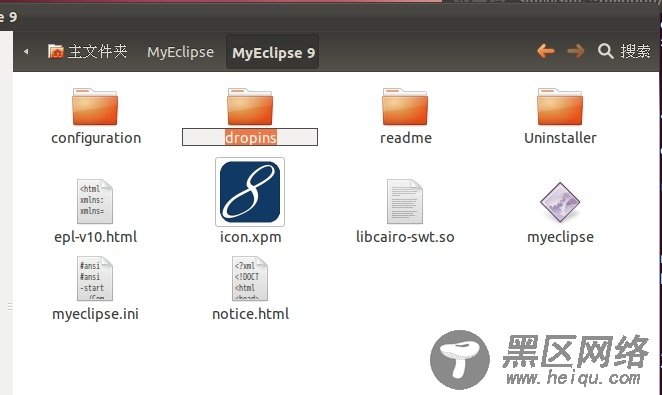

接下来安装Myeclipse的Hadoop插件,在hadoop的安装路径里找到hadoop的eclipse插件,0.20.2的路径在hadoop安装路径/contrib/eclipse-plugin,将插件复制到myeclipse的安装路径中的dropins文件里

然后重启myeclipse,myeclipse会自动提示你说发现新插件。

安装插件成功,打开Window-->Preferens,你会发现HadoopMap/Reduce选项,在这个选项里你需要配置Hadoop installation directory。配置完成后退出。

之后就是调出mapreduce视图,操作流程是MyEclipse->Window->OpenPerspective->other->勾选show all->看见一个小象Map/Reduce 就是它了。

到目前你已经安装成功好hadoop插件了,接下来就是配置hadoop插件使它连上你的hadoop平台。

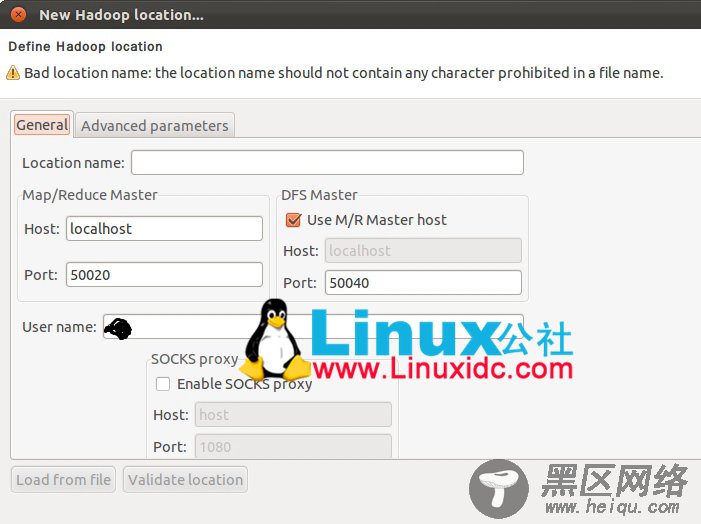

在Map/Reduce Locations中新建一个Hadoop Location。在这个View中,右键选择New Hadoop Location。在弹出的对话框中你需要配置Location name,如myHadoop,还有Map/Reduce Master和DFS Master。这里面的Host、Port分别为你在mapred-site.xml、core-site.xml中配置的地址及端口。

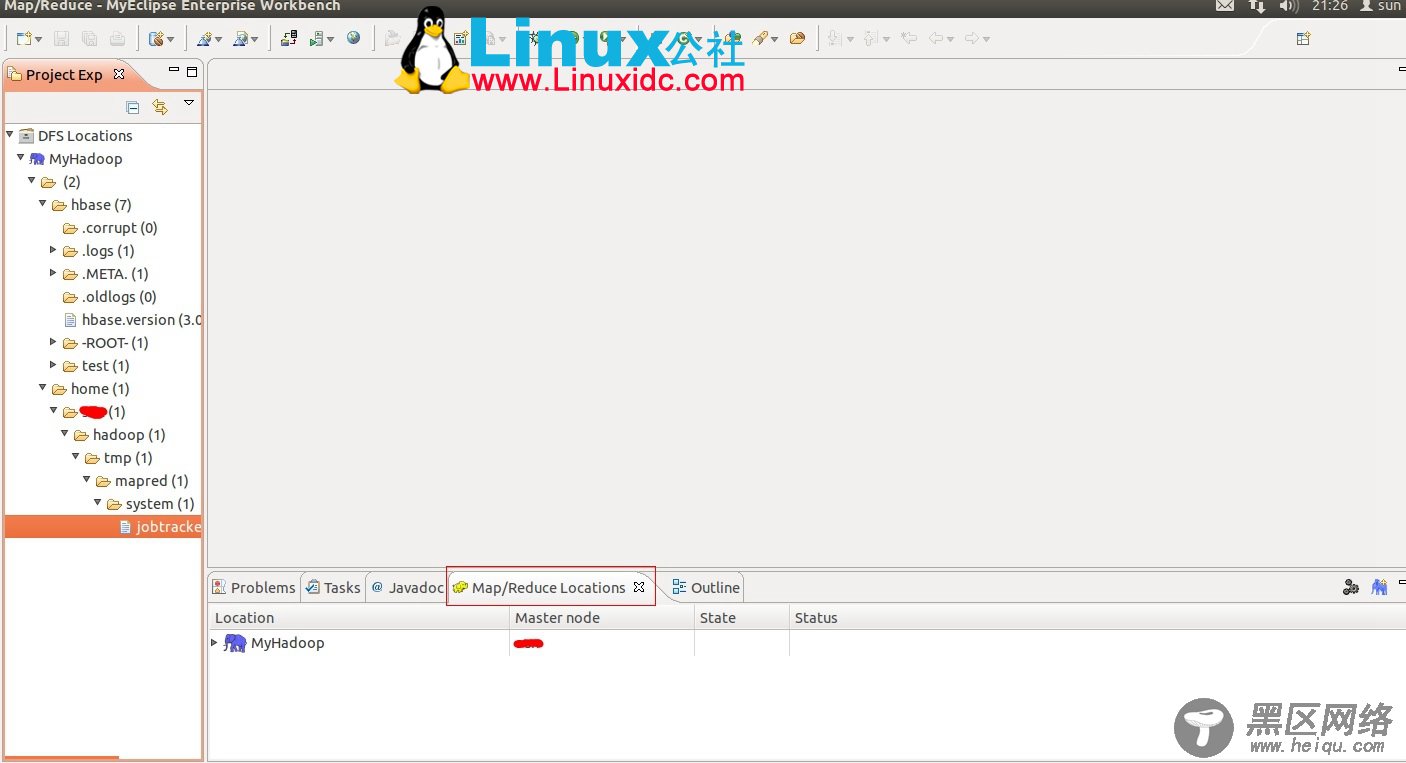

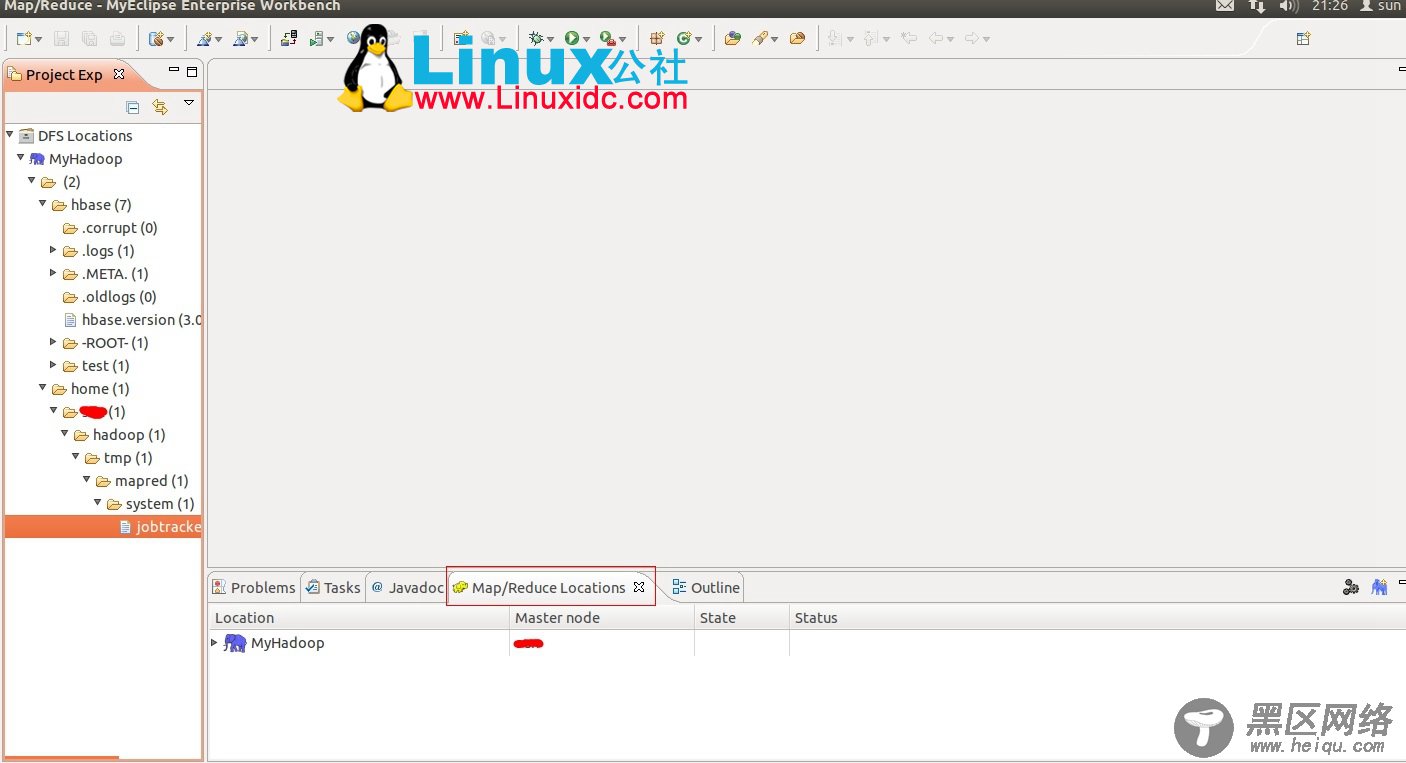

配置完后退出。点击DFSLocations-->myHadoop如果能显示文件夹说明配置正确,如果显示"拒绝连接",请检查你的配置。配置成功的如图

完成上面的一系列操作我们就可以进行开发了,先来个hello world 练练手。

新建项目。

File-->New-->Other-->Map/Reduce Project

项目名可以随便取,如hadoop-helloWorld。

复制 hadoop安装目录/src/example/org/apache/hadoop/example/WordCount.java到刚才新建的项目下面。

上传模拟数据文件夹。

为了运行程序,我们需要一个输入的文件夹,和输出的文件夹。输出文件夹,在程序运行完成后会自动生成。我们需要给程序一个输入文件夹。

1.在当前目录(如hadoop安装目录)下新建文件夹input,并在文件夹下新建两个文件file01、file02,这两个文件内容分别如下:

file01

HelloWorld Bye World

file02

HelloHadoop Goodbye Hadoop

2.将文件夹input上传到分布式文件系统中。

在已经启动Hadoop守护进程终端中cd 到hadoop安装目录,运行下面命令:

bin/hadoopfs -put input input01

这个命令将input文件夹上传到了hadoop文件系统了,在该系统下就多了一个input01文件夹,你可以使用下面命令查看:

bin/hadoopfs -ls

运行项目。

1.在新建的项目hadoop-test,点击WordCount.java,右键-->Run As-->Run Configurations

2.在弹出的Run Configurations对话框中,点Java Application,右键-->New,这时会新建一个application名为WordCount

3.配置运行参数,点Arguments,在Program arguments中输入“你要传给程序的输入文件夹和你要求程序将计算结果保存的文件夹”,如:

hdfs://localhost:9000/user/xx/input01hdfs://localhost:9000/user/xx/output01

这里面的input01就是你刚传上去文件夹。文件夹地址你可以根据自己具体情况填写。

4.点击Run,运行程序。

点击Run,运行程序,过段时间将运行完成,等运行结束后,可以在终端中用命令:

bin/hadoopfs -ls

查看是否生成文件夹output01。

用下面命令查看生成的文件内容:

bin/hadoopfs -cat output01/*

如果显示如下,恭喜你一切顺利,你已经成功在eclipse下运行第一个MapReduce程序了。

Bye1

Goodbye 1

Hadoop2

Hello2

World2

--------------------------------------分割线 --------------------------------------

CentOS安装和配置Hadoop2.2.0