提示一:根据每个OSD的pg数量关闭集群健康警告。通常,第一个变量被设置为30,如果OSD中的每个“in”平均少于30个pg,集群就会发出警告。

提示二:此变量默认值为300,如果OSD中的每个“in”平均超过300个pg,集群就会发出警告,在本实验的小集群中可能没有很多pg,因此采用禁用。

提示三:根据某个池中对象的数量大于集群中一组池中对象的平均数量,关闭集群健康警告。同样,我们有一个非常小的集群,这避免了通常指示我们需要调优集群的额外警告。

3.7 正式部署Ceph集群[student@servera ~]$ cd /usr/share/ceph-ansible/ [student@servera ceph-ansible]$ ansible-playbook site.yml

提示:若部署成功,则对于每个MON节点,前面的命令输出应该显示failed=0。在playbook执行过程中,可能会有许多非致命的警告,它们不会被当做“失败”任务,可以忽略。

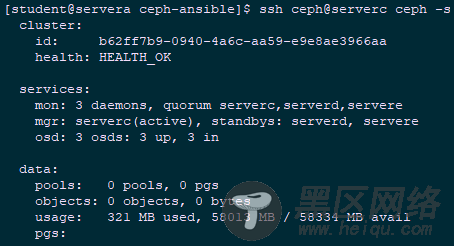

3.8 确认验证Ceph集群[student@servera ~]$ ssh ceph@serverc ceph -s

[student@servera ~]$ ssh ceph@serverc cat /etc/ceph/ceph.conf

[student@servera ~]$ ssh ceph@serverc ps aux | grep ceph-mon

[student@servera ~]$ cd /usr/share/ceph-ansible/group_vars/

[student@servera group_vars]$ sudo cp osds.yml.sample osds.yml

[student@servera group_vars]$ sudo vi osds.yml

---

dummy:

osd_scenario: "collocated" #OSD使用并列的OSD形式

devices:

- /dev/vdb #使用/dev/vdb作为后端存储设备

3.10 配置Ansible Inventory

[student@servera ~]$ sudo vi /etc/ansible/hosts

[mons]

server[c:e]

[mgrs]

server[c:e]

[osds]

server[c:e] #追加osds组

[student@servera ~]$ cd /usr/share/ceph-ansible/ [student@servera ceph-ansible]$ ansible-playbook site.yml

提示:若部署成功,则对于每个OSD节点,前面的命令输出应该显示failed=0。在playbook执行过程中,可能会有许多非致命的警告,它们不会被当做“失败”任务,可以忽略。

3.12 确认验证OSD节点[student@servera ~]$ ssh ceph@serverc ceph -s

[student@servera ~]$ ssh ceph@serverc ceph -w #使用此命令监视集群事件

提示:ceph -w命令将继续显示集群的运行状况和当前事件。要终止该命令,可按ctrl+c。

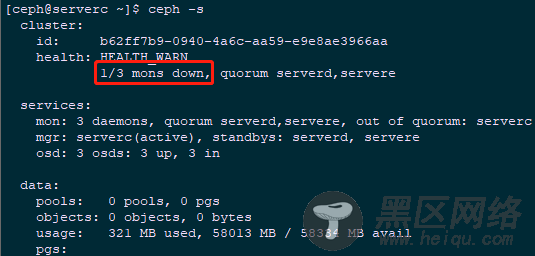

3.13 测试及验证[ceph@serverc ~]$ sudo systemctl stop ceph-mon.target #停止serverc的mon进程 [ceph@serverc ~]$ ceph -s #观察Ceph状态

[ceph@serverc ~]$ sudo systemctl start ceph-mon.target #重启开启mon进程 [ceph@serverc ~]$ sudo systemctl stop ceph-osd.target #停止serverc的osd进程 [ceph@serverc ~]$ ceph -s #观察Ceph状态

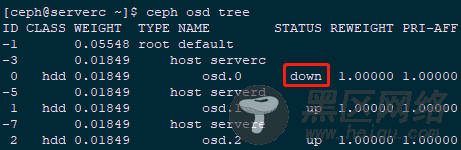

[ceph@serverc ~]$ ceph osd tree #查看osd情况

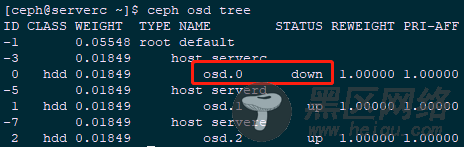

[ceph@serverc ~]$ sudo systemctl start ceph-osd.target #重启开启osd进程 [ceph@serverc ~]$ sudo systemctl stop ceph-osd@0 #停止serverc的osd id为0的进程 [ceph@serverc ~]$ ceph osd tree #查看osd情况

[ceph@serverc ~]$ sudo systemctl start ceph-osd@0 #重启开启osd 0进程 [ceph@serverc ~]$ ceph -s #观察Ceph状态

[ceph@serverc ~]$ ceph -v #查看Ceph版本

3.14 创建client.yml