当然,用户也可以配置外部的glusterfs、ceph、sheepdog等基于服务器的分布式存储。对于glusterfs,应该是可以直接通过菜单挂载;对于ceph,需要通过iscsi协议挂载;对于sheepdog,需要手工安装sheepdog插件,然后在命令行配置挂载。glusterfs挂载后可以作为文件存储使用,ceph和sheepdog应该都只能作为卷存储使用了。

前面多次提到了文件存储和卷存储两个概念,又有什么区别呢?主要是Proxmox对于存储使用是有多种需求的,例如对于虚拟磁盘,就有raw,qcow2,vmdk三种,另外还有iso镜像文件、gz容器模版文件、虚拟机备份文件的保存需求,这些都需要文件存储才可以实现。当然,用户也可以直接用用lvm逻辑卷或zvol逻辑卷或rbd卷的方式保存虚拟机的磁盘,相当于raw格式的效果,这就可以使用卷存储来实现。

那么,说了那么多,到底该怎么配置和选择呢?简单总结下,一般的配置是这样。

本地磁盘-本地目录-文件存储

本地磁盘-lvm-卷存储

本地磁盘-zfs-卷存储/文件存储

本地磁盘-ceph-卷存储

外部存储-nfs-文件存储

外部存储-iscci/fc-lvm-卷存储

外部存储-iscsi/fc-目录-文件存储

外部glusterfs-glusterfs插件挂载-文件存储

外部ceph-iscsi-卷存储

外部sheepdog-插件挂载-卷存储

#在每个节点上安装ceph,详见https://pve.proxmox.com/pve-docs/chapter-pveceph.html

root@proxmox231:~# pveceph install --version luminous root@proxmox232:~# pveceph install --version luminous root@proxmox233:~# pveceph install --version luminous

#配置ceph集群存储网络

root@proxmox231:~# pveceph init --network 192.168.5.0/24

#创建ceph集群存储Mon监控

root@proxmox231:~# pveceph createmon root@proxmox232:~# pveceph createmon root@proxmox233:~# pveceph createmon

#创建mgr

root@proxmox231:~# pveceph createmgr root@proxmox232:~# pveceph createmgr root@proxmox233:~# pveceph createmgr

#创建Ceph OSDs

root@proxmox231:~# pveceph createosd /dev/sdb root@proxmox232:~# pveceph createosd /dev/sdb root@proxmox233:~# pveceph createosd /dev/sdb

#创建集群存储资源池ceph osd pool create [资源池名称] 128 128

root@proxmox231:~# ceph osd pool create pvepool 128 128 pool 'pvepool' created

#复制存储ID和密钥到指定文件位置

root@proxmox231:~# mkdir /etc/pve/priv/ceph root@proxmox231:~# cp /etc/ceph/ceph.client.admin.keyring /etc/pve/priv/ceph.keyring root@proxmox231:~# cp /etc/pve/priv/ceph.client.admin.keyring /etc/pve/priv/ceph/ceph1.keyring

root@proxmox231:~# ceph osd pool application enable pvepool rbd enabled application 'rbd' on pool 'pvepool'

#查看集群状态

root@proxmox231:~# ceph -s cluster: id: 2cd9afcd-fd20-4e52-966b-3252c6444e6c health: HEALTH_OK services: mon: 3 daemons, quorum proxmox231,proxmox232,proxmox233 mgr: proxmox231(active), standbys: proxmox232, proxmox233 osd: 3 osds: 3 up, 3 in

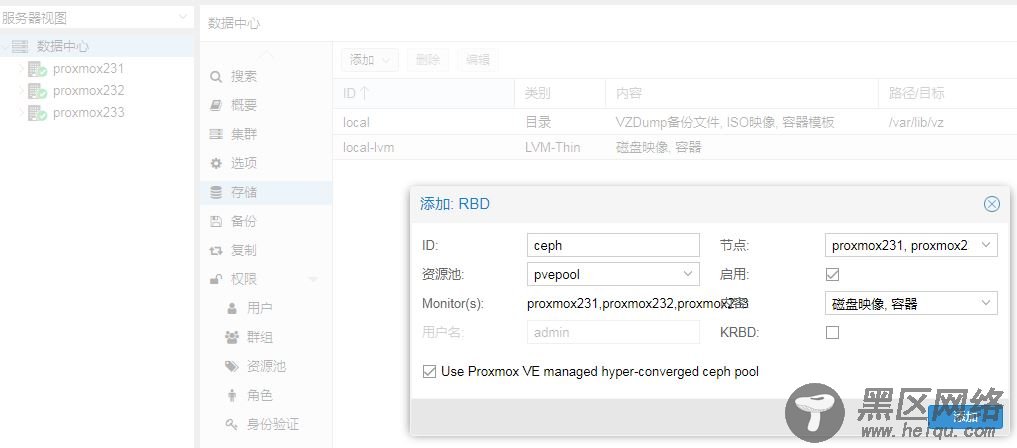

#添加RBD集群存储

ID:填写为ceph 必填,不能定义

资源池:pvepool 可选(默认为rbd)

Monitor:192.168.5.231 192.168.5.232 192.168.5.233 (注意添加多个Mon以空格隔开)

添加节点:proxmox231,proxmox232,proxmox233

#查看rbd集群存储配置信息

root@proxmox231:~# cat /etc/pve/storage.cfg dir: local path /var/lib/vz content vztmpl,iso,backup lvmthin: local-lvm thinpool data vgname pve content images,rootdir rbd: ceph content images,rootdir krbd 0 nodes proxmox233,proxmox231,proxmox232 pool pvepool

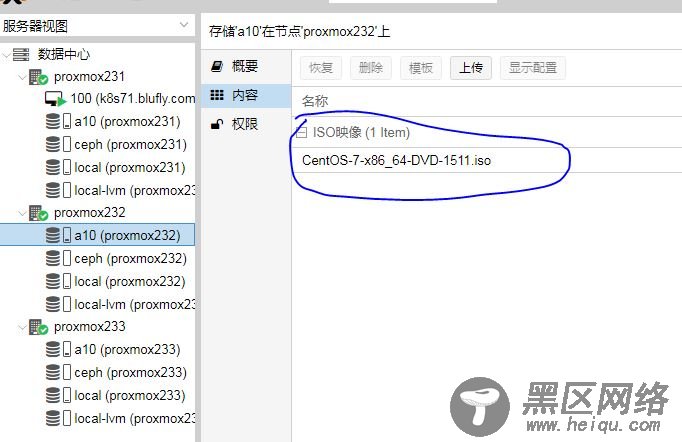

#上传ISO镜像,通过sftp上传到以下目录/var/lib/vz/template/iso,但这里上传的iso只能本机显示,如果要让集群中其它的主机也能共享iso,那就要用到共享存储,刚好内网上有一台NFS服务器,exsi存储用的,上面也有ISO镜像,正好可以共享,于是在数据中心上挂载这个NFS存储

#新建虚拟机,使用ceph存储

#虚拟机热迁移测试

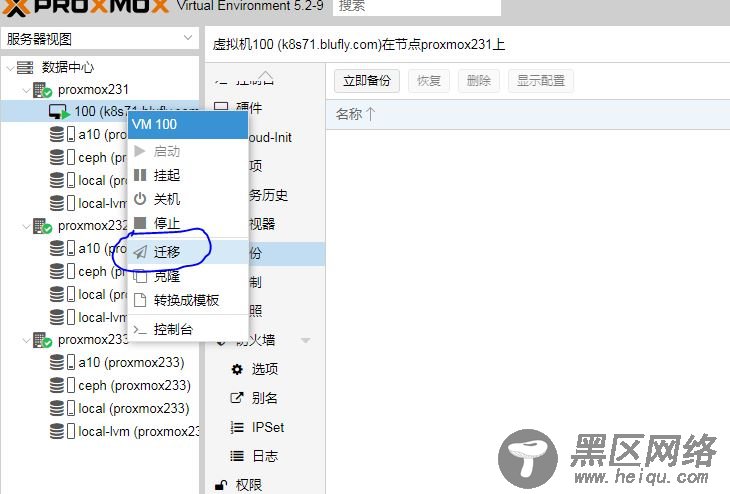

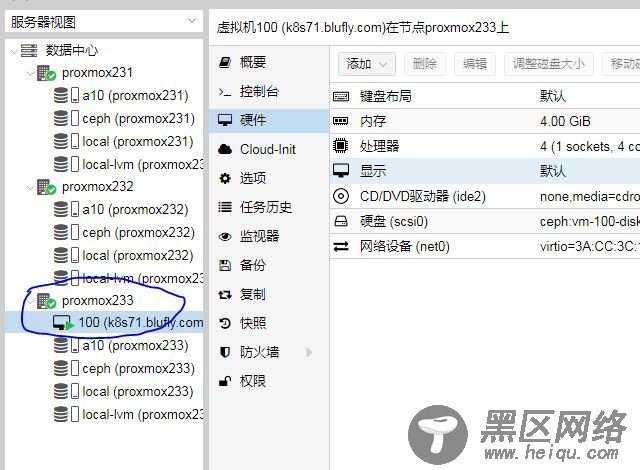

刚刚在proxmox231上创建了一个centos7的虚拟机,存储用到了ceph,所以先来进行热迁移测试,将proxmox231上的虚拟迁移到proxmox233上面

2018-09-29 15:50:16 starting migration of VM 100 to node 'proxmox233' (192.168.5.233)

2018-09-29 15:50:16 found local disk 'local:iso/CentOS-7-x86_64-DVD-1804.iso' (in current VM config)

2018-09-29 15:50:16 can't migrate local disk 'local:iso/CentOS-7-x86_64-DVD-1804.iso': can't live migrate attached local disks without with-local-disks option

2018-09-29 15:50:16 ERROR: Failed to sync data - can't migrate VM - check log

2018-09-29 15:50:16 aborting phase 1 - cleanup resources

2018-09-29 15:50:16 ERROR: migration aborted (duration 00:00:01): Failed to sync data - can't migrate VM - check log

TASK ERROR: migration aborted

#在迁移的时候报错,那是因为在安装的时候挂载了本地的ISO,所以在迁移之前先修改下虚拟的配置,CD/DVD选择不使用任何介质

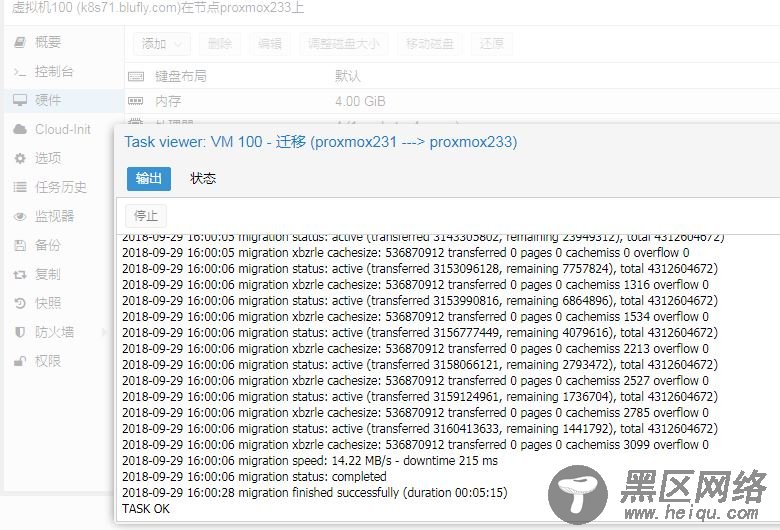

#然后再来迁移

#此时之前在proxmox231上面运行的虚拟已经迁移到proxmox233上面来了

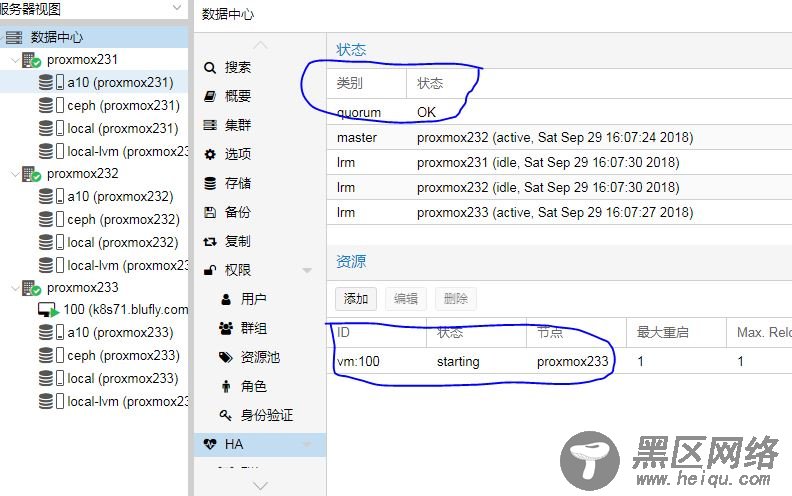

#将虚拟机加入HA,进行高可用测试

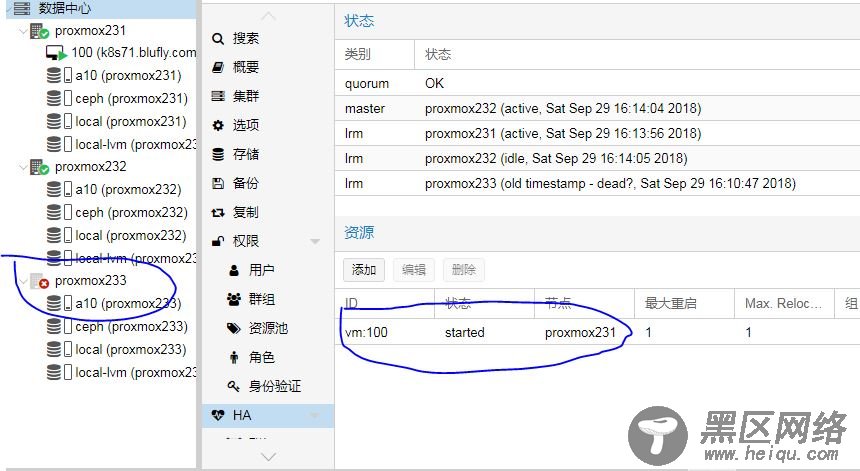

#好了,已成功将proxmox233上面的k8s71.blufly.com虚拟机添加到HA,现在将proxmox233关机模拟故障

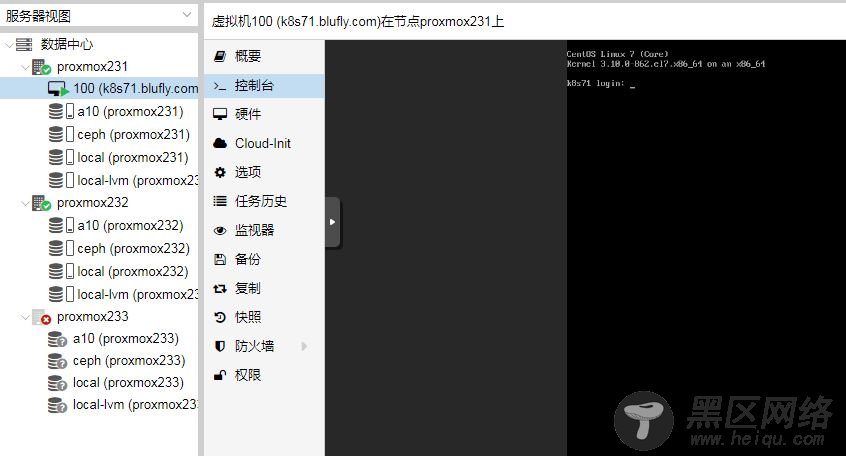

#从截图上可以看到proxmox233已经故障,k8s71.blufly.com这个虚拟机已经迁移到proxmox231上了,实现了高可用

以上只是对proxmox做了简单的测试,基本上能满足日常需求,更多的高级功能后面再来慢慢摸索。

Linux公社的RSS地址:https://www.linuxidc.com/rssFeed.aspx