开拓情况总体版本信息如下:

1、Linux:CentOS 6.8

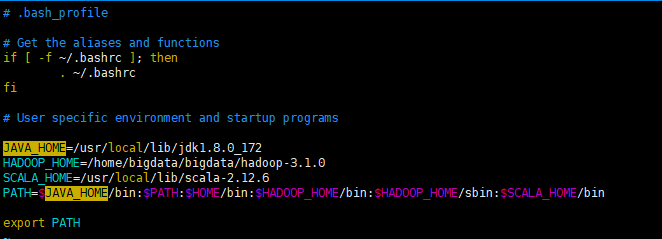

2、Java版本:jdk-8u172-linux-x64.tar.gz

3、Hadoop版本:hadoop-3.1.0.tar.gz

4、scala版本:scala-2.12.6.tgz

5、Python版本:Python-3.6.5.tgz

6、spark版本:spark-2.3.0-bin-hadoop2.7.tgz

7、zookeeper版本:zookeeper-3.4.10.tar.gz

8、hive版本:

9、kafka版本:

10、处事器集群:192.168.0.110(master),192.168.0.111(slave1),192.168.0.112(slave2)

一、java的安装

1、上传jdk安装包到/usr/local/lib目次下,并解压缩

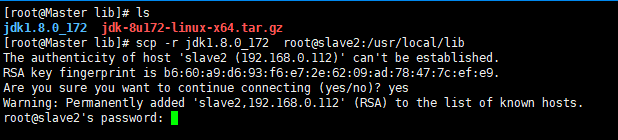

2、把解压的文件夹复制到别的两台机子

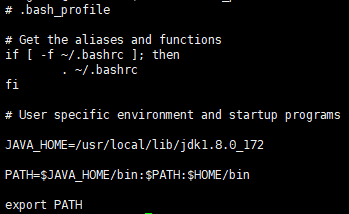

3、三台处事器别离修改bigdata用户的情况变量

4、使设置生效并验证

二、hadoop的安装

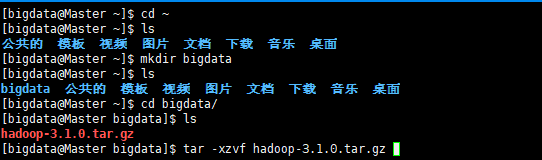

1、bigdata用户家目次下建设目次bigdata,上传hadoop安装包并解压

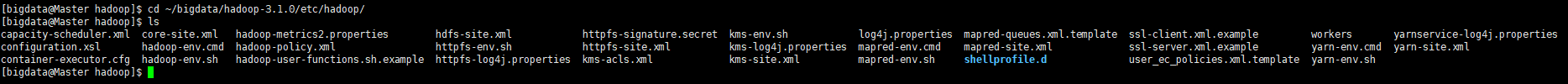

2、进入hadoop设置文件目次,修改hadoop设置

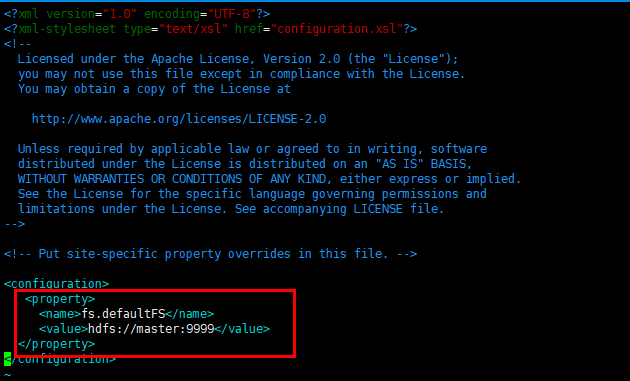

3、修改core-site.xml,添加赤色方框的内容

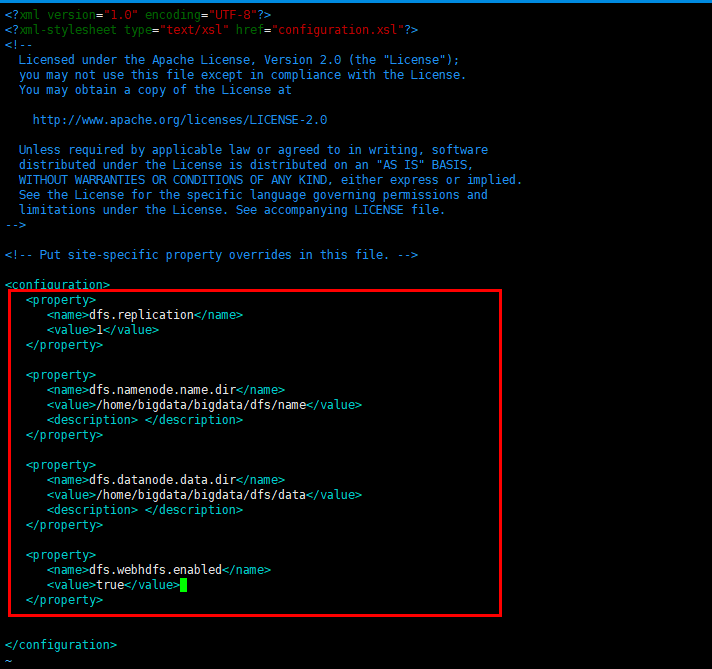

4、修改hdfs-site.xml,并建设对应的目次

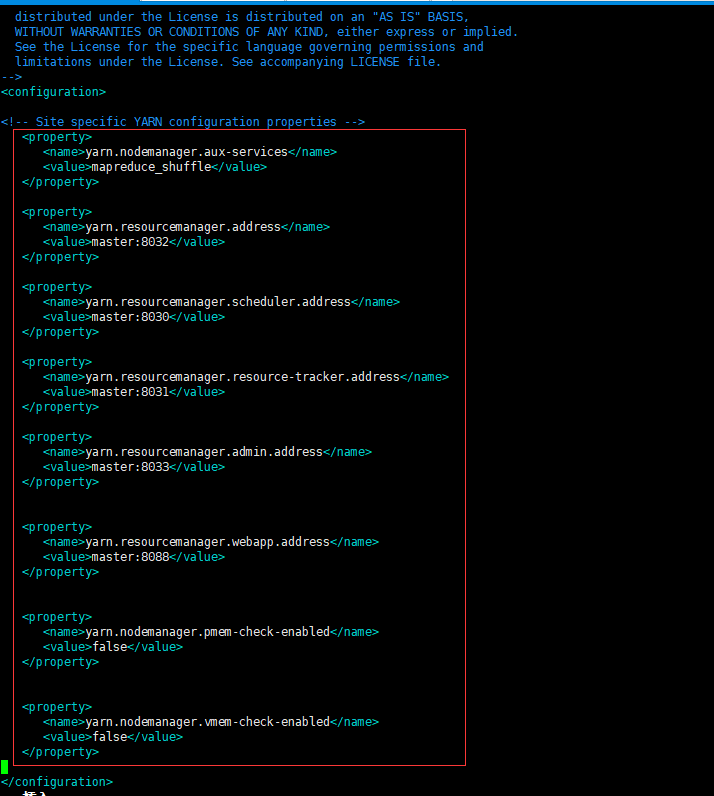

5、修改yarn-site.xml

6、修改workers(老版本为slaves)

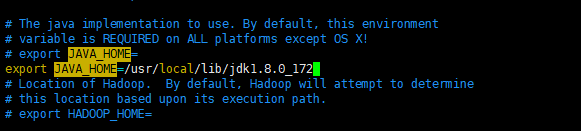

7、修改hadoop-env.sh,增加JAVA_HOME

8、把master上设置好的hadoop分发到每一个slave上

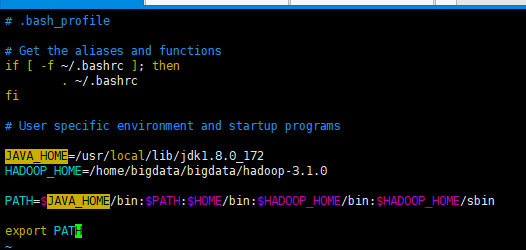

9、只需在master上bigdata用户下设置情况变量

10、使情况变量生效并查抄

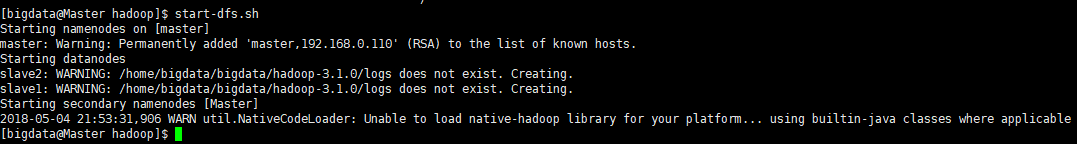

11、首次运行hdfs,需要先名目化hdfs【 hdfs namenode -format 】,然后启动hdfs【start-dfs.sh】

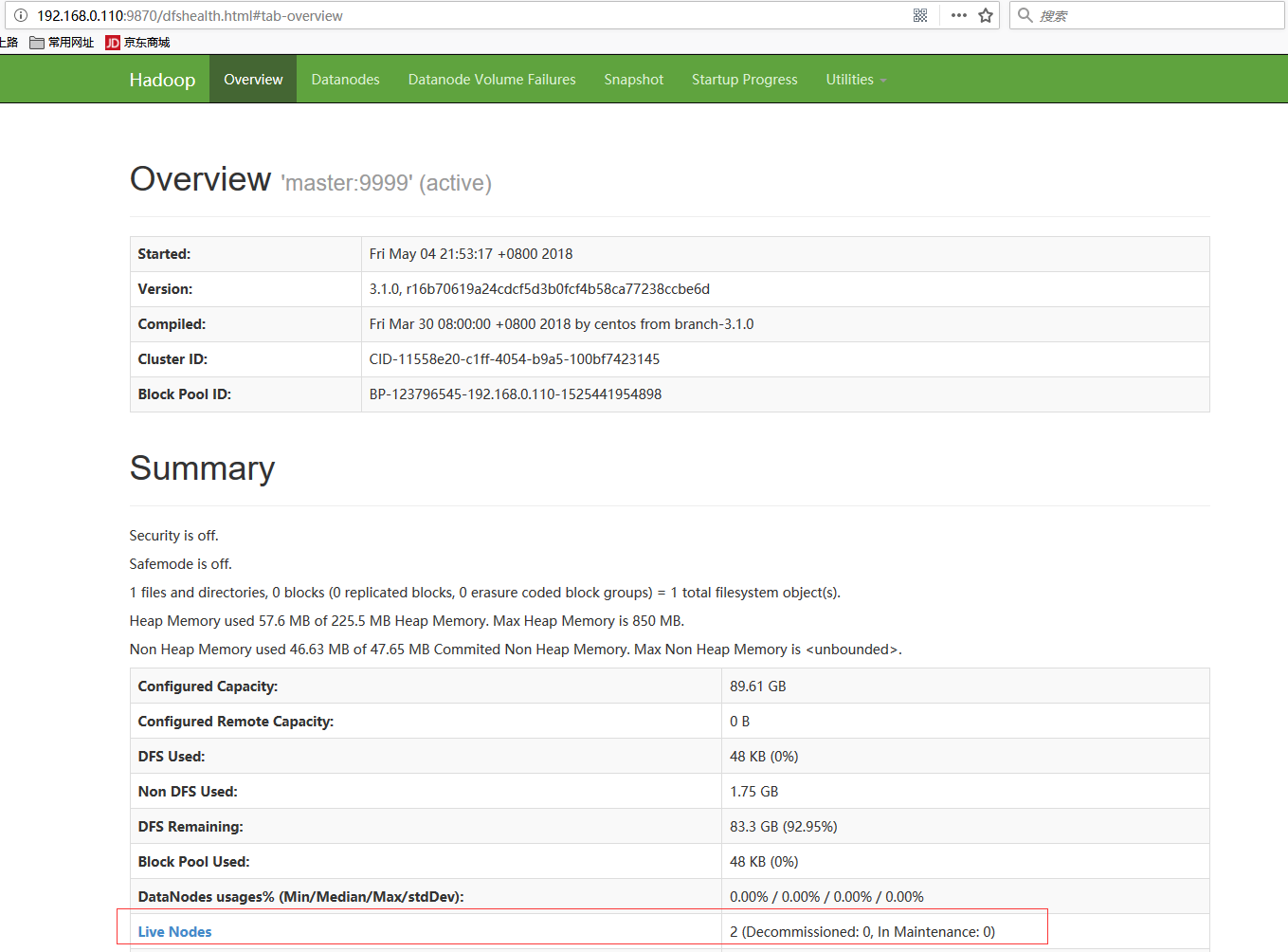

12、可会见:9870【192.168.0.110为master的ip地点,老版本hadoop的端口为50070】看下是否陈设乐成;如需遏制hdfs,利用【stop-dfs.sh】

13、也可输入名jps,查察是否有以下历程

14、启动yarn【start-yarn.sh】

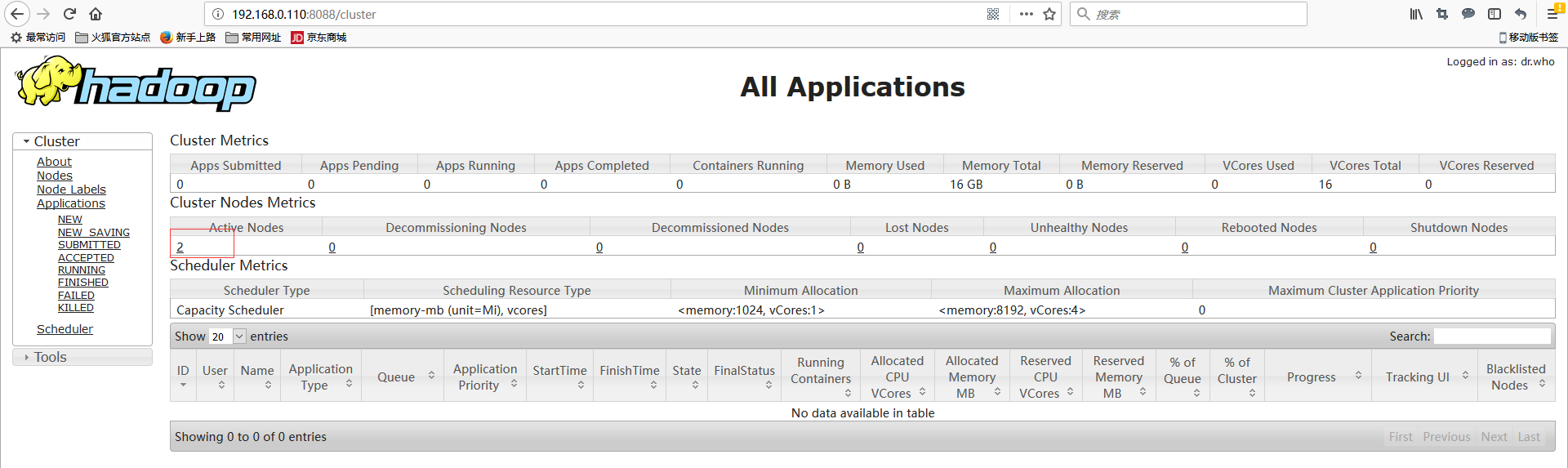

15、会见:8088/cluster,查察yarn是否正常事情,遏制yarn利用【stop-yarn.sh】

16、也可输入名jps,查察是否有以下历程

综上,hadoop集群安装完毕!

三、scala的安装

1、切换到root用户下,下载scala并上传到/usr/local/lib目次下,然后解压

2、把解压后的文件分发到slave1和slave2

scp -r scala-2.12.6 root@slave1:/usr/local/lib

scp -r scala-2.12.6 root@slave2:/usr/local/lib

3、别离在三台处事器上修改bigdata用户的情况变量

4、验证情况变量是否生效

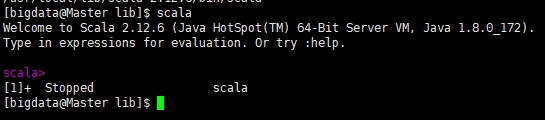

5、运行scala呼吁验证是否安装乐成,并按ctrl+z退出

四、python的安装

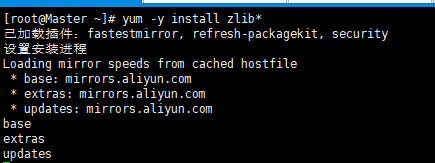

1、在集群上运行pyspark,需要先安装zlib和gcc相关的软件包

yum -y install gcc*

2、下载python安装包,并上传,然后解压

3、进入/usr/local/lib/,修改Modules/Setup.dist【老版本是Setup】,找到赤色一行,并把注释去掉

4、执行./configure

5、make

6、make install

7、查察系统原有python版本,并重定名

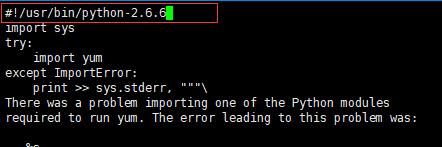

8、修改/usr/bin/yum

9、从头成立python的软毗连

7、执行python呼吁,查抄是否安装好

五、spark的安装

1、下载并上传spark安装文件到bigdata用户家目次下的bigdata目次下,然后解压

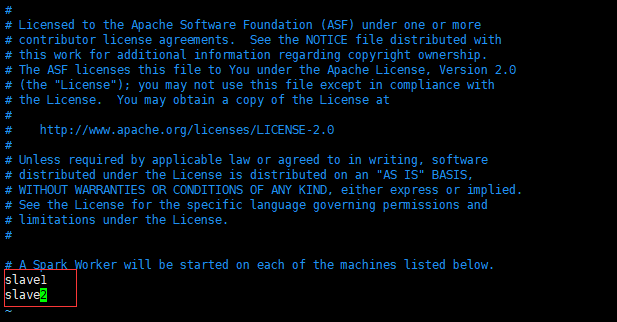

2、设置slaves

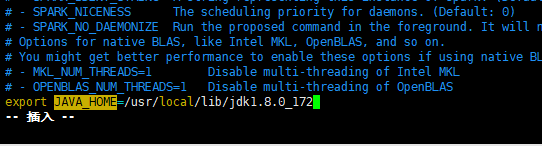

3、设置spark-env.sh

4、把设置好的spark分发slave1和slave2上面

scp -r ~/bigdata/spark-2.3.0-bin-hadoop2.7 bigdata@slave1:~/bigdata

scp -r ~/bigdata/spark-2.3.0-bin-hadoop2.7 bigdata@slave2:~/bigdata

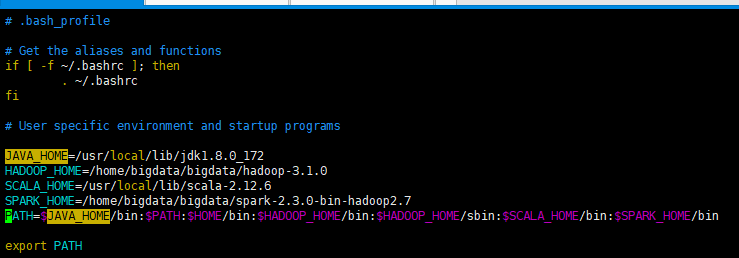

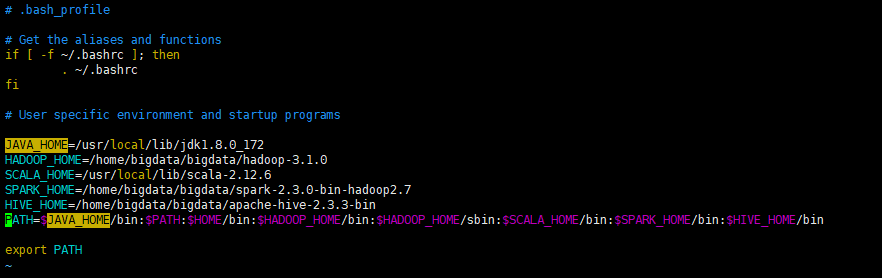

5、在master上设置情况变量

source ~/.bash_profile

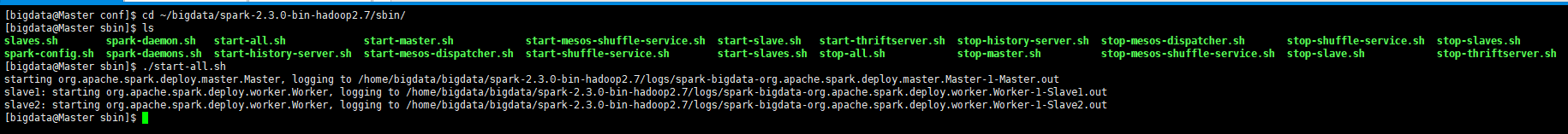

6、启动spark

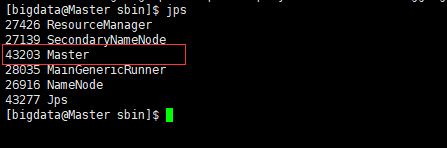

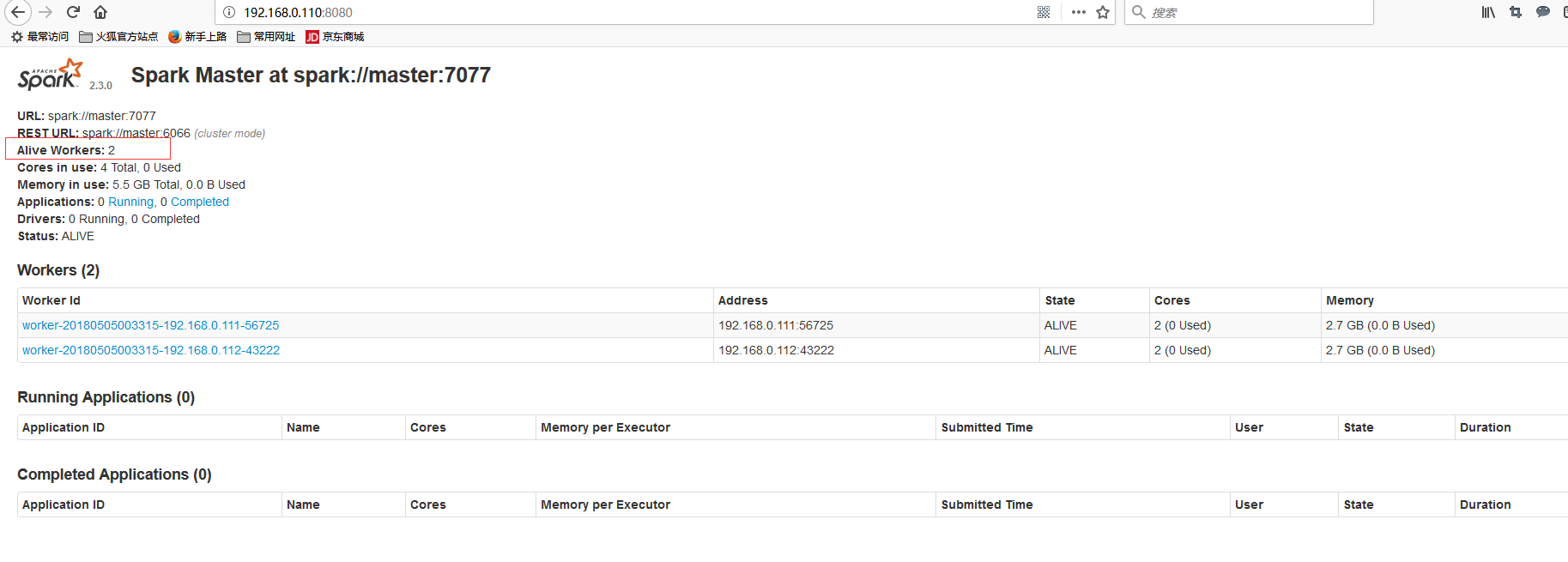

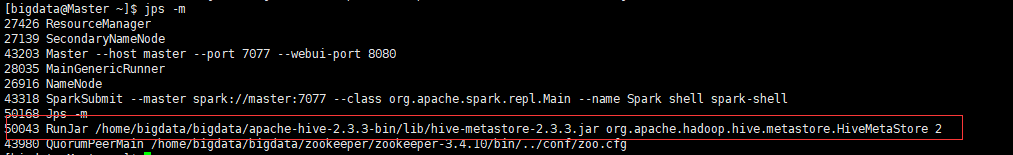

7、确认spark已经启动【jps呼吁,可能会见:8080】

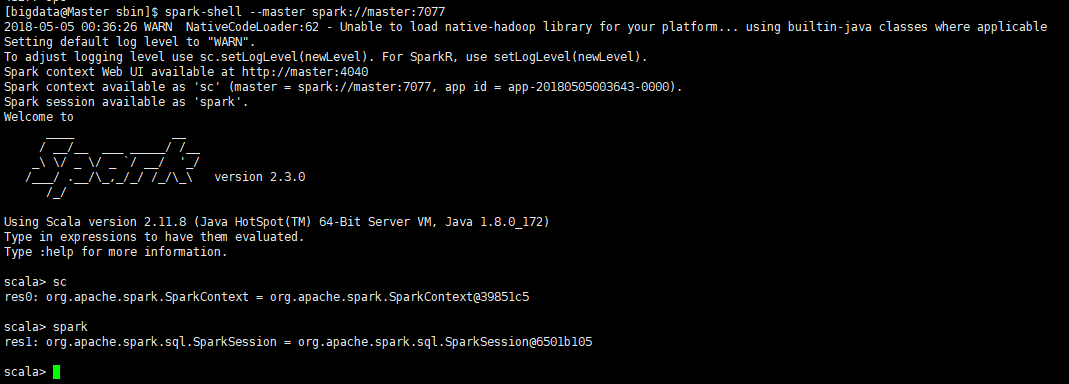

8、测试spark代码【ctrl+z退出】

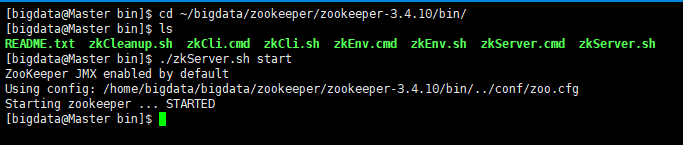

六、zookeeper的安装

1、下载并上传zookeeper文件,然后解压

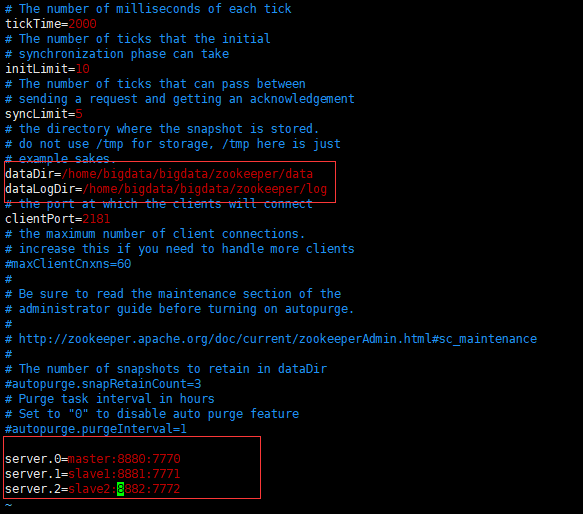

2、修改设置文件

3、建设设置文件设置的目次

4、将设置好的zookeeper分发到slave1和slave2

5、别离在3台处事器的~/bigdata/zookeeper/data目次中新增文件myid并修改

master上myid的内容为:0

slave1上myid的内容为:1

slave2上myid的内容为:2

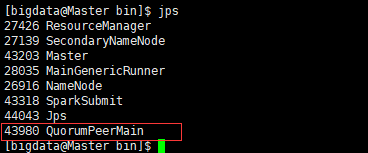

6、别离到3台处事器中启动节点zk处事

7、查察每一个处事器上的zk的状态

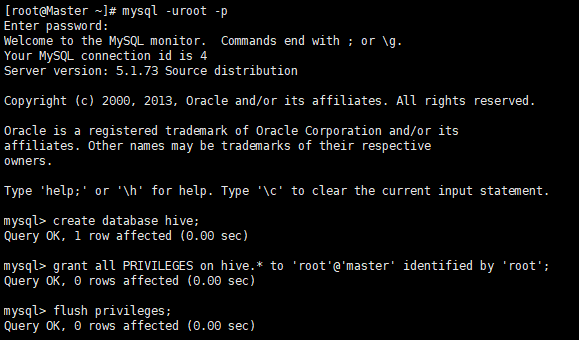

七、hive的安装

1、安装MySQL

安装:yum install -y mysql-server

启动:service mysqld start

修改root用户暗码:mysqladmin -u root password 'root'

建设数据库hive并授权:

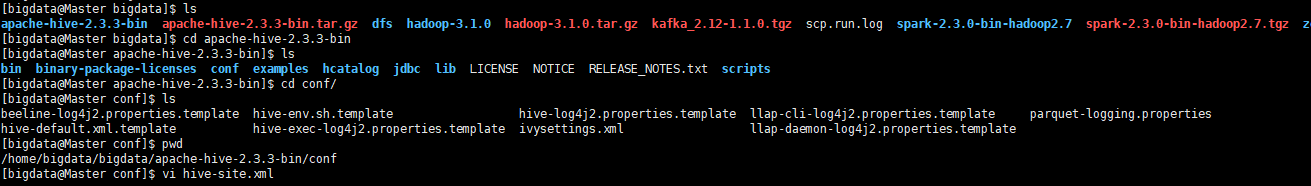

2、下载并上传hive安装包,然后解压

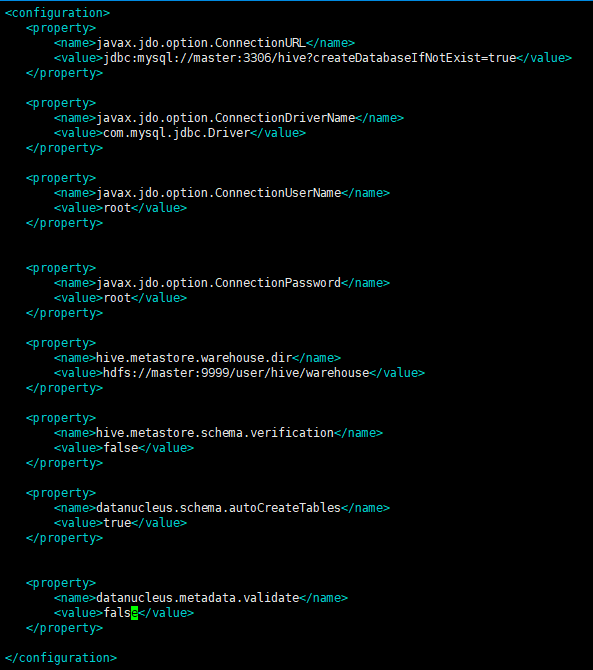

3、进入设置目次【/home/bigdata/bigdata/apache-hive-2.3.3-bin/conf】,修改设置文件hive-site.xml

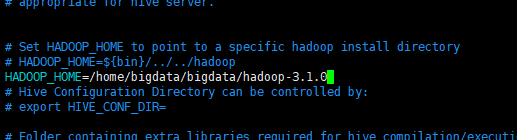

4、编辑hive-env.sh

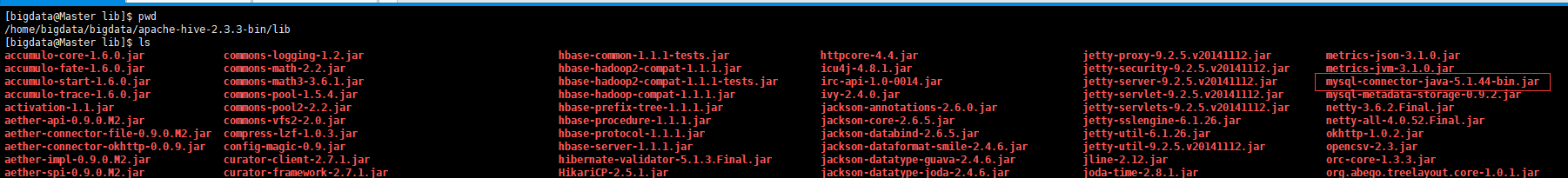

5、下载mysql的jdbc驱动mysql-connector-java-5.1.44-bin.jar,上传/home/bigdata/bigdata/apache-hive-2.3.3-bin/lib

6、设置master的情况变量

source ~/.bash_profile

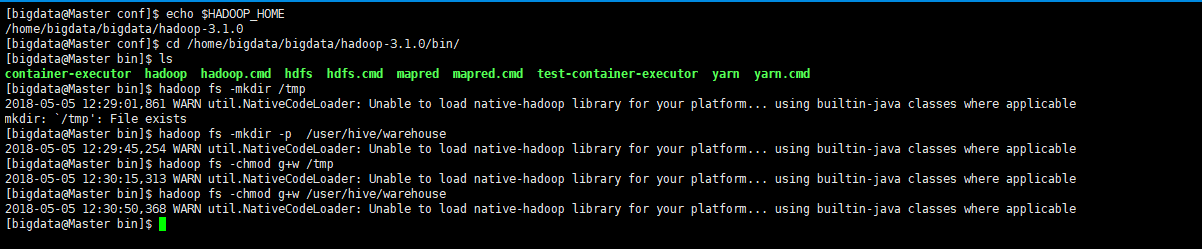

7、建设hive-site.xml内里设置的目次并授权

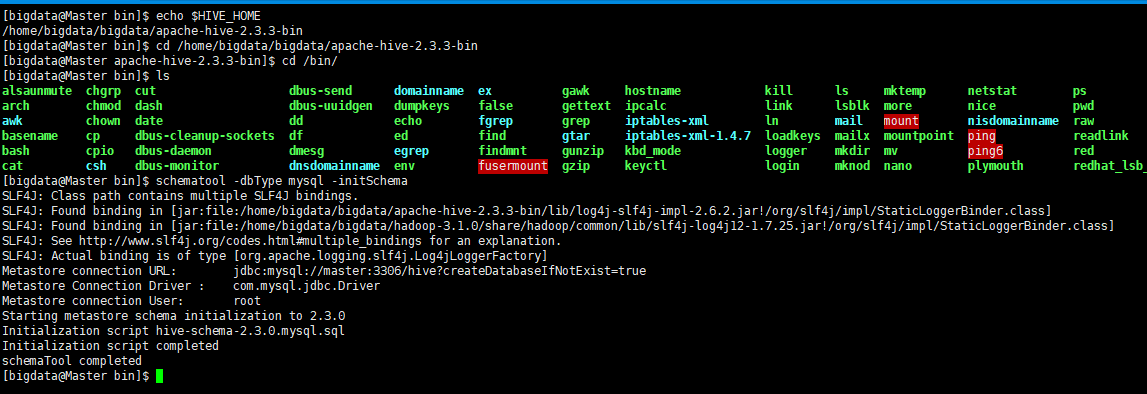

8、指定hive数据库范例并初始化

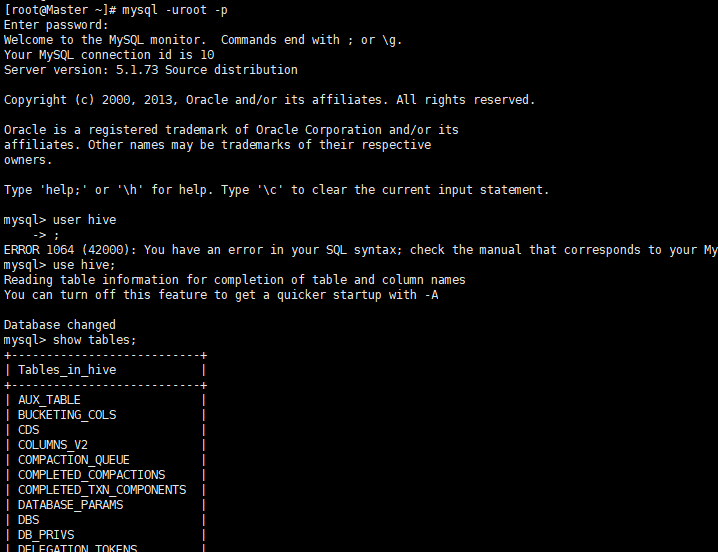

9、验证hive的mysql数据库是否安装乐成【hive数据库下面是否有表】

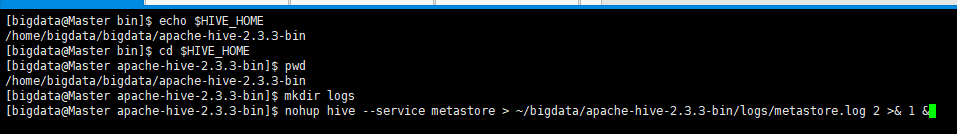

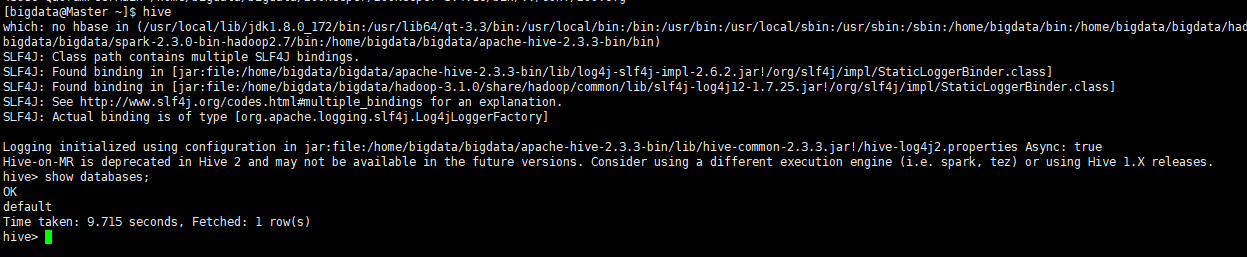

10、运行hive前首先要确保meta store处事已经启动:先建设hive运行日志目次logs,再运行HIVE

验证:

运行HIVE

八、kafka的安装

1、下载kafka并上传,然后解压

2、建设日志目次,修改设置文件

mkdir /home/bigdata/bigdata/kafka-logs-new

3、将kafka分发到slave1 和 slave2

4、别离修改slave1和slave2上面的server.properties文件

slave1:broker.id=1

slave2:broker.id=2

5、别离在三台处事器上启动broker server

nohup bin/kafka-server-start.sh config/server.properties>~/bigdata/kafka_2.12-1.1.0/logs/server.log 2>&1 &

6、在master上建设topic

7、查察topic

8、启动producer发送动静

9、启动consumer消费动静

10、结果如下