Director对于LVS来说,是重中之重,所有对服务的请求都要经过它 向他身后提供服务的集群进行转发,但它也是LVS高负载均衡集群的不稳定因素,如果Director主机宕机,后方的服务集群也就不能够提供服务了,这是坚决不允许出现的情况,因此我们可以通过为Director提供高可用集群服务来保证当一个Director宕机之后,还有其它的Director可以替代提供服务,知道宕机的Director重新恢复。

我们使用高可用集群解决方案之一 ——Heartbeat来实现这个目的

我们先来考虑一个问题,当Director的主节点宕机之后,必须要将资源转移到备节点上,否则备节点也只是摆设,并不能替代宕机的主节点来完成Director的工作。关键就在这个资源转移的方法上。

Heartbeat为LVS中的Director实现高可用集群量身定做了套解决方案,我们只需要在Heartbeat的几个配置文件中进行简单的配置,我们所需要的目的都统统能够实现,不仅如此,它自身还具备了帮我们检测后方服务集群中主机服务状态的功能,简直让我们喜出望外,下面我们就通过一个简单的实验来阐明这个观点。

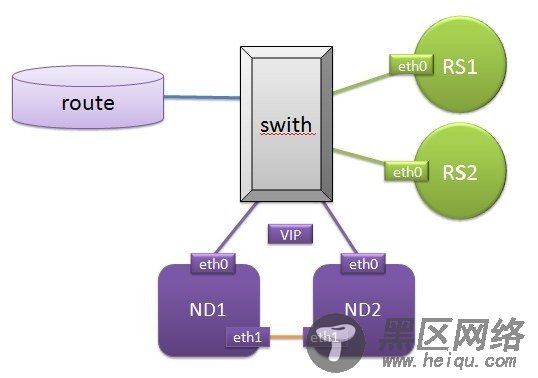

实验拓扑如图:

我们要实现的LVS的类型为DR,即直接路由

route为连接外网的路由器,switch为内网中的交换机,RS1、RS2为提供web服务的集群,直接和交换机相连,ND1、ND2为LVS中的两个Director节点,我们要对这连个Director节点实现高可用集群服务,两个Director和交换机直接相连之外,两个节点之间还需要直接连接进行心跳等基本信息的传递。

每个有标记的块状物为网卡,上面是编号,在连个ND节点之间有一个被称为资源一部分的VIP在哪个节点上是不固定的,外网的用户也是通过这个VIP来访问我们的web服务的。

开始配置: 设定VIP为192.168.0.85/24

一、我们先来RS1和RS2让其称为一个web服务的集群

1、对RS1的配置

(1)、对realserver配置内核参数:

先来解释一下修改内核参数的原因,因为在DR模型中RS1、RS2在lo:0上都配置了VIP的地址,是为了在数据包响应用户的时候源地址为用户访问的VIP地址,但是在数据包进入路由器之后,在我们的内网中有多个VIP地址,路由器将不能将其转发到应该得到数据包的ND上,为了避免这种情况出现,我们就修改内核参数来让RS上的VIP网卡不对路由器的产生响应即可。

echo 1 > /proc/sys/net/ipv4/conf/lo/arp_ignore

echo 1 > /proc/sys/net/ipv4/conf/all/arp_ignore

echo 2 > /proc/sys/net/ipv4/conf/all/arp_announce

echo 2 > /proc/sys/net/ipv4/conf/lo/arp_announce

(2)、为RS1配置虚拟的VIP地址(是为了实现在数据包返回用户的时候源地址为用户访问的地址)

ifconfig lo:0 192.168.0.85 broadcast 192.168.0.85 netmask 255.255.255.255 up

为RS1的eth0网卡添加地址

ifconfig eth0 192.168.0.206/24

(3)、给realserver主机添加路由信息

route add -host 192.168.0.85 dev lo:0 设定相应的数据包的源地址都为这个地址

(4)、为RS1安装web服务

yum install php php-mbstring mysql mysql-server httpd php-mysql

(5)、为实现结果为web指定一个有其代号的网页,并写一个有ok的测试网页

echo RS1 > /var/www/html/index.html

echo ok > /var/www/html/.ok.html

(6)、测试httpd服务能否正常运行,测试结果如下: