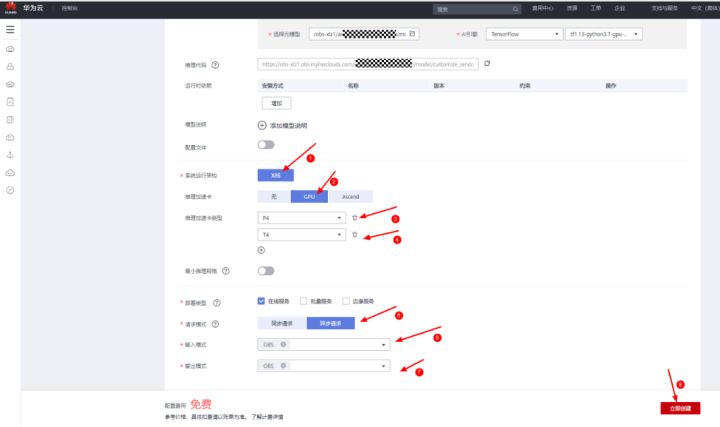

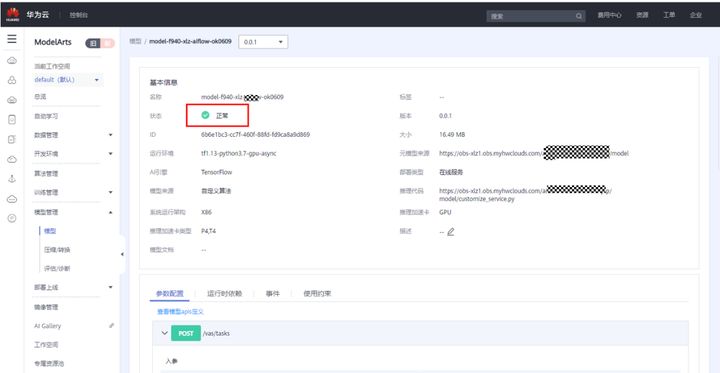

可以看到模型创建成功:

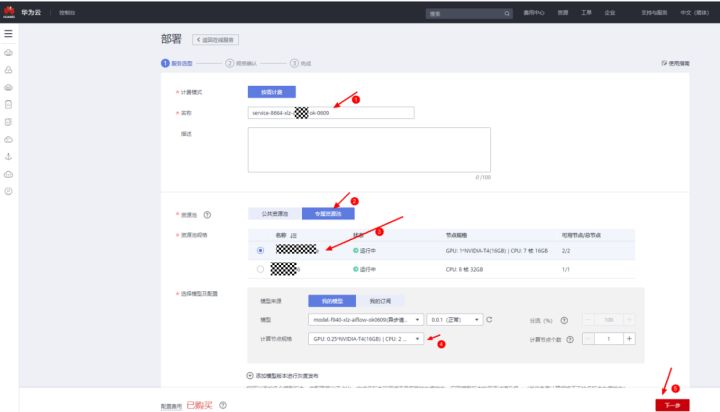

4).部署服务,将上述模型部署为在线服务,部署中要选择有GPU的资源节点(公共池和专属池都可以):

可以看到服务已经部署成功:

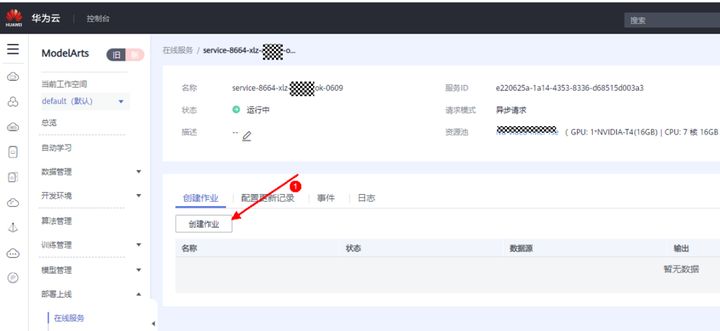

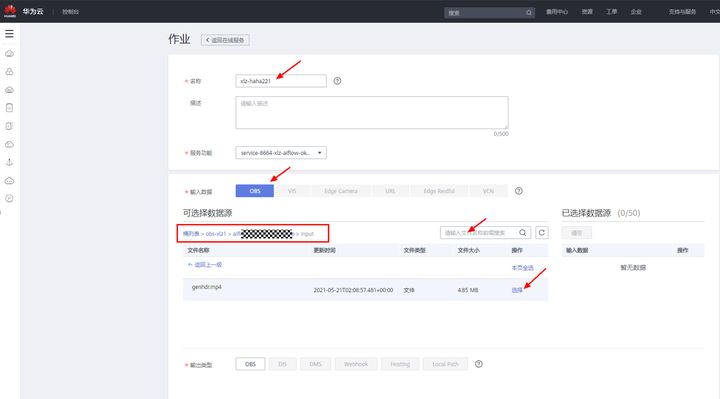

5)创建作业:在服务界面选择创建作业

选择输入视频,选到步骤2)中上传到OBS中的input文件夹中的视频文件如下:

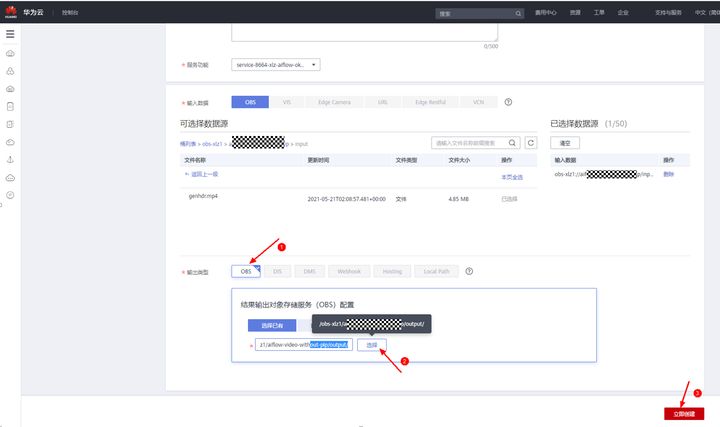

选择输出路径,选到步骤2)中上传到OBS中的output文件夹如下:

6)等待视频处理完成:

查看OBS中的output文件夹,可看到视频已被拆成图片后的推理结果了。

7)用户根据自己需要,更换model文件夹下的“saved_model”格式的模型文件,并修改“customize_service.py”中的“_preprocess”和“_postprocess”函数来完成自己的业务逻辑。修改完后可以先运行“test/run_test.sh”来提前验证下修改后的模型包是否能正常推理,待线下调试好,可正常推理后再按上述步骤将模型包提交到OBS中部署成Modelarts服务。

其中,视频推理的模型包要求如下:

模型包结构要求:

└── model

├── config.json (必须,Modelarts推理相关的配置文件)

├── customize_service.py (必须,推理文件)

├── saved_model.pb (必须,SavedModel格式的模型文件)

└── variables (必须,SavedModel格式的模型文件)

├── variables.data-00000-of-00001

└── variables.index

其中config.json 文件的格式遵循Modelarts的规范,https://support.huaweicloud.com/engineers-modelarts/modelarts_23_0092.html