1)监督学习: 有train set,train set里面y的取值已知。

2)无监督学习:有train set, train set里面y的取值未知。

3)半监督学习:有train set, train set里面y的取值有些知道有些不知道。

4)增强学习:reinforcement learning, 无train set。

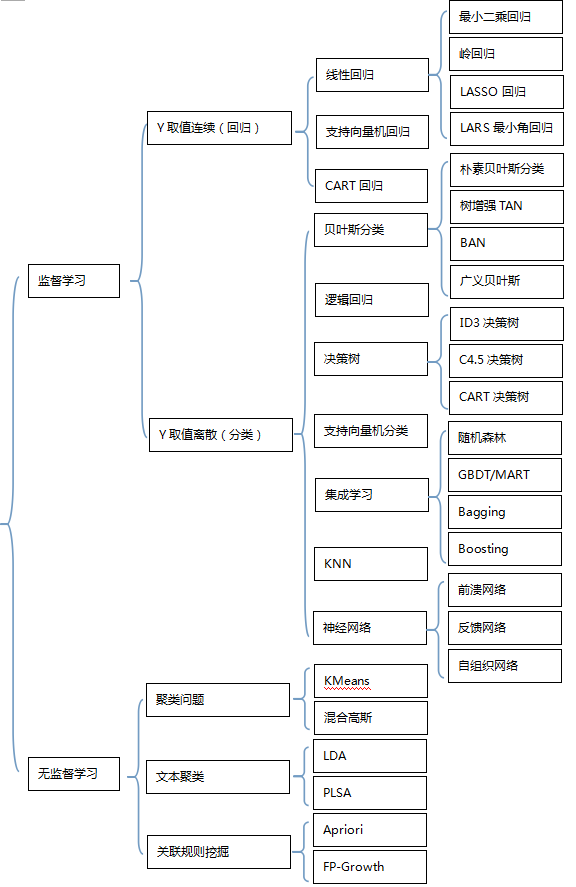

2,常见算法

最小二乘回归(英文名:Ordinary Least Squares RegressionOLS, 又叫Generalized Least SquaresGLS)是常见的线性回归方法。最小二乘法的基本原则是:最优拟合直线应该使各点到直线的距离的和最小,也可表述为距离的平方和最小。

经典线性回归模型的基本假设:(1),残差具有零均值;(2)var <∞,即残差具有常数方差,且对于所有x值是有限的;(3)残差项之间在统计意义上是相互独立的;(4)残差项与变量x无关;(5)残差项服从正态分布;

如果满足假设(1)-(4),由最小二乘法得到的估计量具有一些特性,它们是最优线性无偏估计量(Best Linear Unbiased Estimators,简记BLUE)。1)线性(linear):意味着x与随机变量y之间是线性函数关系;2)无偏(unbiased):意味着平均而言,实际由样本数据得到的x的参数值与其总体数据中的真实值是一致的;3)最优(best):意味着在所有线性无偏估计量里,OLS估计量具有最小方差。

回归常见的3个必须要解决的问题在于:

1)Heterroskedasticity异方差性: 残差的方差不为常数, 残差与x相关(eg,x变大,残差变大), 违反了假设2和4

2)Autocorrelation自相关性:残差项之间自相关,违反了假设3

3)Multicollinearity多重共线性:多个x之间不独立,即xi与xj之间存在相关性。

2)岭回归岭回归(英文名:ridge regression, Tikhonov regularization)是一种专用于共线性数据分析的有偏估计回归方法,实质上是一种改良的最小二乘估计法(OLS回归),通过放弃最小二乘法的无偏性,以损失部分信息、降低精度为代价获得回归系数更为符合实际、更可靠的回归方法,对病态数据的拟合要强于最小二乘法。

一般线性回归是最小二乘法回归,残差计算是平方误差项。岭回归(Ridge Regression)是在平方误差的基础上增加正则项,通过确定的值可以使得在方差和偏差之间达到平衡:随着的增大,模型方差减小而偏差增大。

岭回归是对最小二乘回归的一种补充,它损失了无偏性,来换取高的数值稳定性,从而得到较高的计算精度。通常岭回归方程的R平方值会稍低于普通回归分析,但回归系数的显著性往往明显高于普通回归,在存在共线性问题和病态数据偏多的研究中有较大的实用价值。

备注:回归问题时,如果x选择个数太多,会导致模型复杂度膨胀性增大。如果x选择太少,可能导致模型的预测能力不够。x选择数目过多,一方面太复杂,另外一方面会使得构建出来的模型对train set的数据over-fit,导致这个模型应用于test set时效果并不好。因此需要有一个机制来做特征选择,即需要对x的集合有所取舍。特征选择有3种类型:1)子集选择;2)收缩方法(Shrinkage method),又叫做正则化(Regularization),这里就会出现岭回归方法和LASSO回归方法。3)维数缩减,即降维

3)LASSO回归LASSO回归(英文名: Least Absolute Shrinkage and Selectionator Operator)其实本质是一种降维方法, 由Tibshirani(1996)提出。这种算法通过构造一个惩罚函数获得一个精炼的模型;通过最终确定一些指标的系数为零,LASSO算法实现了指标集合精简的目的。这是一种处理具有复共线性数据的有偏估计。Lasso的基本思想是在回归系数的绝对值之和小于一个常数的约束条件下,使残差平方和最小化,从而能够产生某些严格等于0的回归系数,得到解释力较强的模型。

4)LARS回归LARS回归(英文名: Least Angle Regression,最小角回归)。Efron于2004年提出的一种变量选择的方法,类似于向前逐步回归(Forward Stepwise)的形式。从解的过程上来看它是LASSO回归的一种高效解法。

最小角回归和模型选择比较像,是一个逐步的过程,每一步都选择一个相关性最大的特征,总的运算步数只和特征的数目有关,和训练集的大小无关。最小角回归训练时的输入为特征矩阵 X={X1,X2,...,XP},和期输出向量Y={y1,y2,...,yN},Xi 是长度为N的矩阵,N表示训练集的大小,P则是特征的数目。还有一点需要注意的是,向量Xi 和 Y 都是正则化之后的向量,即它们的元素的均值为0,且每个向量的长度都是1,这样做的目的是为了后面计算相关性以及角度的方便。