一、创建DataFrame和Dataset 1.1 创建DataFrame

Spark 中所有功能的入口点是 SparkSession,可以使用 SparkSession.builder() 创建。创建后应用程序就可以从现有 RDD,Hive 表或 Spark 数据源创建 DataFrame。示例如下:

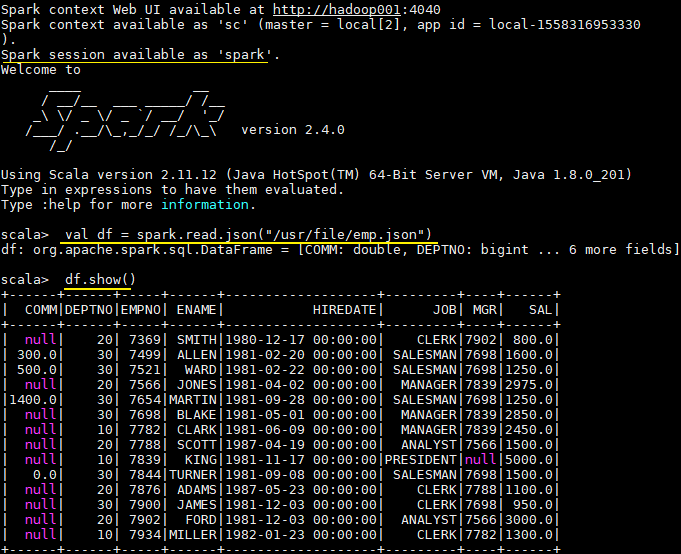

val spark = SparkSession.builder().appName("Spark-SQL").master("local[2]").getOrCreate() val df = spark.read.json("/usr/file/json/emp.json") df.show() // 建议在进行 spark SQL 编程前导入下面的隐式转换,因为 DataFrames 和 dataSets 中很多操作都依赖了隐式转换 import spark.implicits._可以使用 spark-shell 进行测试,需要注意的是 spark-shell 启动后会自动创建一个名为 spark 的 SparkSession,在命令行中可以直接引用即可: