本文分享自华为云社区《INTERSPEECH2020 语音情感分析论文总结一》,原文作者:Tython。

1. Learning Utterance-level Representations with Label Smoothing for Speech Emotion Recognition(INTERSPEECH2020)(1)数据处理:IEMOCAP四分类,leave-one-speaker-out,unweighted accuracy。openSMILE对短时帧提取147维LLDs特征。

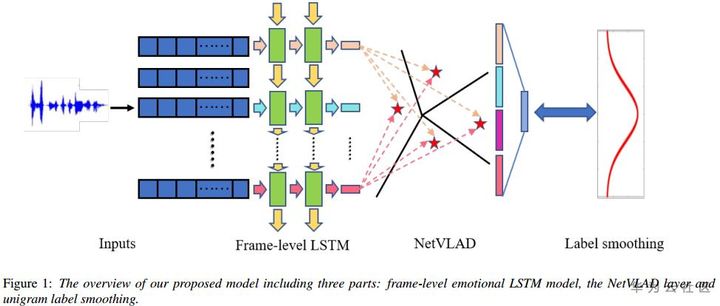

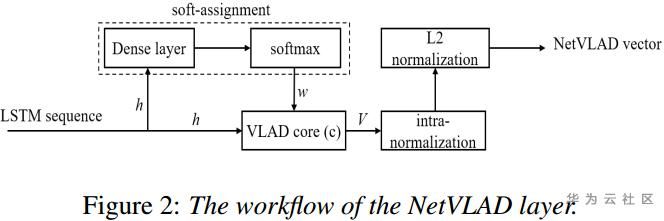

(2)模型方法:采用LSTM对一句话的多个segment的特征序列建模,输出的特征序列经过NetVLAD进行聚类压缩,由原来的N*D的维度降为K*D,再对降维后的特征进行softmax分类。在类别标签上,作者采用标签平滑(label smoothing)策略,即在训练过程中,加入非匹配的(X,y)数据对,也叫作label-dropout(dropping the real labels and replace them with others),并分配一个权值小的标签。以此提升模型的适应性,减少过拟合。

(3)NetVLAD源自图像特征提取方法的一种VLAD,通过对图像的特征向量聚类,得聚类中心并做残差,将一个若干局部特征压缩为特定大小全局特征的方法。具体可参考https://zhuanlan.zhihu.com/p/96718053

(4)实验:NetVLAD可看作一种pooling方法,最后WA达62.6%,高出weighted-pooling2.3个百分点。label smoothing前后的效果分别是59.6%和62%,相差两个百分点。

(5)总结:最大的贡献在于对每个frame的特征进行NetVLAD做类似池化操作,筛选有用特征;另外在训练方式上也引入label smoothing操作,提升效果两个点。

(1)数据处理:IEMOCAP数据四分类,Session1-4训练,Session5测试。特征提取23维的log-Mel filterbank。

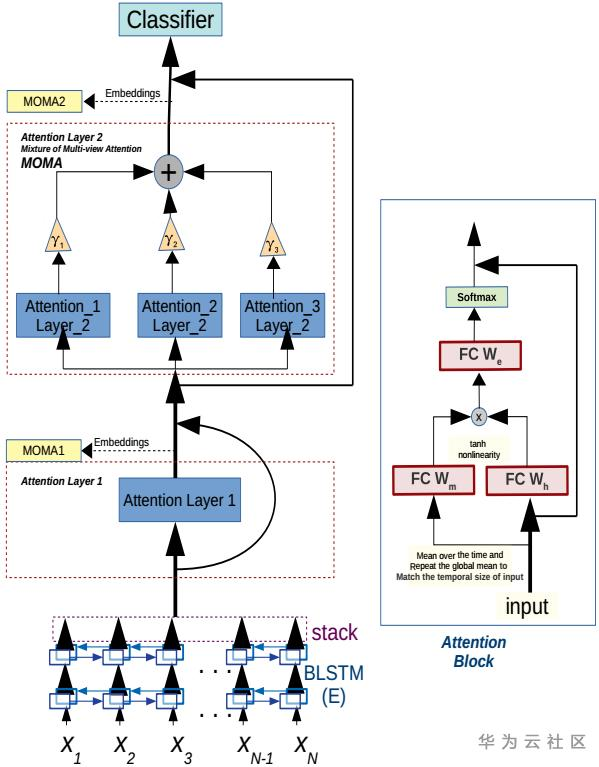

(2)模型方法:一个Utterance分成N帧,依次输入BLSTM(Hidden layer 512 nodes),得到N*1024大小的矩阵,输入第一个Attention layer 1。将该layer的输出合上原始的矩阵一起分别输入三个Attention_i_Layer_2,该三个attention层分别独立并受超参数gama控制。然后将三个输出求和,并输入一个全连接层(1024 nodes),最后softmax层做分类。

(3)实验:采用WA,UA作为评价指标,但是文章定义UA错误,UA的定义实际为WA。而WA的定义也存疑。实验效果UA达80.5%,实为segment-level的Accuracy。并没有通用的句子级的Accuracy,也是评价的一个trick。

(4)总结:论文的创新主要对经过BLSTM的特征进行多个Attention操作,作为MOMA模块,取得显著的效果提升。但是该提升只体现在segment-level的准确率,参考意义不大。

(1)数据处理:IEMOCAP数据四分类,leave-one-speaker-out。STFT汉明窗提取频谱特征,窗长分别为20ms, 40ms,窗移10ms。

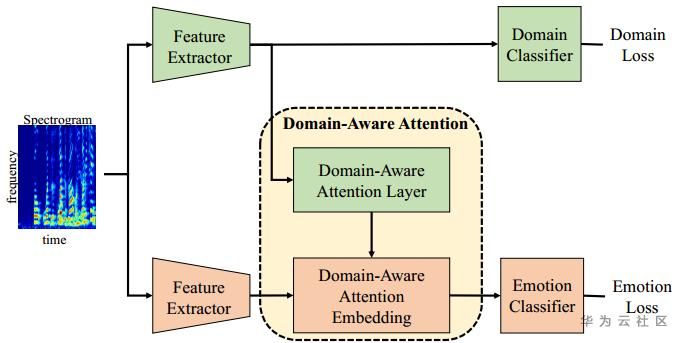

(2)模型方法:输入同一频谱图,分成两部分,一部分到Domain-Aware Attention模块(time pooling, channel pooling and fully connected layer, respectively),另一部分至Emotion模块,做time pooling, channel-wise fully connected(各channel分别全连接)。然后Domain模块输出一个向量,将向量变成对角矩阵,与Emotion模块的输出矩阵相乘,使得领域信息融入到emotion embedding。最后多任务学习,分别求Domain loss和Emotion loss。这里的Domain并不是指不同领域的数据,而是指性别、年龄等额外信息。

(3)实验:WA达到73.02%,UA达到65.86%,主要对Happy情绪的分类不准确。相比单任务emotion分类,多任务WA高出3%,WA高出9%。

(4)总结:论文实质上就是多任务学习,以此提升情绪分类效果。